Wiadomość została wysłana.

Przetworzymy Twoją prośbę i skontaktujemy się z Tobą tak szybko, jak to możliwe.

Formularz został pomyślnie przesłany.

Więcej informacji można znaleźć w skrzynce pocztowej.

Każdy chce mieć inteligentne funkcje, automatyzację i moc predykcyjną. Dopóki nie nadejdzie czas na ich integrację. W ciągu ponad 10 lat budowania funkcji opartych na AI w rzeczywistych aplikacjach widziałem, jak "wyprzedzające swoje czasy" systemy AI często nie integrują się z powodu zaskakująco prostych kwestii, takich jak niewłaściwe priorytety w zespołach. Z drugiej strony obserwowałem, jak ciche, mało skomplikowane projekty rozwijają się w coś potężnego, a wszystko to dzięki jasnemu kierunkowi i stałej informacji zwrotnej.

W tym przewodniku przedstawię proste podejście do integracji AI z aplikacją, pomagając przekształcić surowe pomysły w działające rozwiązania.

Żaden system AI nie poradzi sobie ze złymi danymi. Jeśli dane wejściowe są nieuporządkowane, nieaktualne lub niekompletne, nawet najbardziej zaawansowany model będzie miał trudności lub, co gorsza, będzie podejmował decyzje, którym nie można ufać.

Przed przystąpieniem do tworzenia aplikacji należy dokładnie przyjrzeć się dostępnym danym. Czy dane są istotne dla problemu, który próbujesz rozwiązać? Czy są one spójne, aktualne i wystarczająco uporządkowane, by można było z nich korzystać?

Załóżmy, że dane klientów są przechowywane w rozproszonych systemach, gromadzone niespójnie, bez standardowych formularzy. W tym przypadku nie jesteś jeszcze gotowy. Będziesz musiał zainwestować w czyszczenie, konsolidację i walidację tych danych przed czymkolwiek innym. A w scenariuszach o wysokiej stawce, takich jak wykrywanie wad w produkcji lub analiza w czasie rzeczywistym dla pojazdów autonomicznych, ryzyko pominięcia tego kroku szybko rośnie.

Wraz ze wzrostem obciążenia rosną wymagania zarówno wobec infrastruktury, jak i AI.

Modele AI są zasobożerne, zwłaszcza w czasie rzeczywistym, co kończy się wyższymi opóźnieniami i potencjalnymi wąskimi gardłami wydajności w miarę wzrostu przepływu użytkowników. Zaplanuj infrastrukturę automatycznego skalowania, aby obsłużyć skoki, wydajne interfejsy API, aby uniknąć opóźnień, oraz solidną architekturę danych z modułowymi potokami chroniącymi przed niedokładnością.

Jeśli chodzi o model AI, zarządzanie nim na dużą skalę oznacza ciągłą ewolucję. Aby objąć nowe dane lub zmieniające się środowiska, należy go odpowiednio przekwalifikować. Nie jest to nauka o rakietach, ale obowiązkowy element strategii.

Jak już wspomniałem, AI zapewnia rzeczywiste wyniki, gdy rozwiązuje istniejące problemy, a nie te wyimaginowane lub zapożyczone od konkurencji.

Pierwszym krokiem jest więc dokładne dostosowanie oczekiwań biznesowych do wymiernych wyników. AI służy jako potężny asystent biznesowy, który może pomóc w usprawnieniu różnych aspektów, od automatyzacji procesów i oferowania wglądu predykcyjnego po pomoc w usprawnieniu zaangażowania klientów za pomocą inteligentnych narzędzi wsparcia.

Dobrze zdefiniowany cel może przełożyć się na konkretne przypadki użycia, takie jak

Dzięki wczesnemu ustaleniu priorytetów biznesowych, zespół Innowise i ja stworzyliśmy unikalne rozwiązanie AI dla naszego klienta z branży e-commerce — chatbot do wewnętrznej analizy dokumentacji co doprowadziło do 34% wzrost wydajności zespołu.

Gdy cele są jasne, wybór odpowiednich narzędzi staje się prosty. W tym przypadku mój zespół kieruje się poziomem kontroli, szybkością i stopniem dostosowania projektu, a także ilością czasu i budżetem, które klient jest skłonny zainwestować.

Jeśli szukasz pełnej kontroli i głębokiej personalizacji, narzędzia open-source, takie jak TensorFlow lub PyTorch, są najlepszym rozwiązaniem - szczególnie dla dużych przedsiębiorstw. Jeśli priorytetem jest szybkość wprowadzenia produktu na rynek, można skorzystać z interfejsów API i platform zarządzanych, takich jak OpenAI, Google Cloud AI, AWS SageMaker lub Azure AI. Są one często wybierane w przypadku MVP, gdzie szybka dostawa ma największe znaczenie.

Pomocna zasada:

Czy można mieszać? Krótko mówiąc, tak, i jest to strategiczne. Często wdrażamy podejście hybrydowe, gdy jest ono odpowiednie. Nasz zespół opiera się na zastrzeżonych narzędziach, aby przyspieszyć czas wprowadzenia produktu na rynek na etapie MVP, jednocześnie skalując aplikacje na infrastrukturze komercyjnej, zachowując pełną kontrolę i długoterminowe korzyści kosztowe.

Nie wszystkie modele AI są zbudowane tak samo. Niektóre są świetne w wykrywaniu wzorców na obrazach, inne w przetwarzaniu języka lub przewidywaniu wyników na podstawie danych szeregów czasowych. Wybierając niewłaściwy, ryzykujesz niską dokładność, zmarnowane wydatki i rozwiązanie, które zawiedzie w prawdziwym świecie.

Nie chodzi wyłącznie o technologię, ale bardziej o znalezienie odpowiedniego dopasowania do pracy, którą firma musi wykonać.

Na przykład, aby poradzić sobie z wysokowymiarowymi danymi wizualnymi w zadaniach widzenia komputerowego, wykorzystujemy techniki uczenia nadzorowanego, samonadzorowanego i transferowego (więcej szczegółów w tabeli). Podejście to okazało się skuteczne w niedawnym projekcie, w którym zaimplementowaliśmy wizję komputerową w aplikacji platforma zdalnego monitorowania zdrowia, prowadzenie pojazdu 40% szybsze gojenie się ran.

W innym przypadku mój zespół z powodzeniem zastosował analitykę predykcyjną dla klienta z branży bankowej, pomagając mu reaktywacja 17% odrzuconych klientów.

| Obszar zastosowania | Najlepsze przypadki użycia | Typy modeli | Przykłady |

| Analityka predykcyjna | Przewidywanie zmian, prognozowanie popytu, przewidywanie zapasów, prognozowanie obciążenia energetycznego | Głębokie uczenie nadzorowane | Regresja logistyczna, Random Forest, XGBoost, ARIMA |

| NLP | Analiza nastrojów, chatboty, podsumowywanie tekstu | Uczenie nadzorowane, samonadzorowane, uczenie transferowe | BERT, GPT, RoBERTa, spaCy |

| Wizja komputerowa | Klasyfikacja obrazów, wykrywanie obiektów, wizualna kontrola jakości, rozpoznawanie twarzy | Uczenie nadzorowane, samonadzorowane, uczenie transferowe | CNN, YOLO, ResNet, transformatory Vision |

| Systemy rekomendacji | Spersonalizowane sugestie produktów, ranking treści | Nadzór, wzmocnienie, samokontrola | Faktoryzacja macierzy, DeepFM, bandyci, GPT |

| Automatyczne rozpoznawanie mowy | Polecenia głosowe, transkrypcja, identyfikacja mówcy | Nadzorowany, samonadzorowany | Whisper, Wav2Vec, RNNs |

| Wykrywanie anomalii | Monitorowanie błędów, wykrywanie usterek, wykrywanie oszustw i włamań | Nienadzorowane, nadzorowane | Isolation Forest, autoenkodery, jednoklasowa SVM |

| Segmentacja klientów | Kierowanie marketingowe, grupowanie zachowań | Uczenie nienadzorowane | K-Means, DBSCAN, gaussowskie modele mieszane |

| Gra AI / Robotyka | Autonomiczna kontrola, planowanie ścieżki, podejmowanie decyzji w czasie rzeczywistym | Uczenie przez wzmacnianie | Q-Learning, DQN, PPO, AlphaGo |

| Pojazdy autonomiczne | Wykrywanie pasa ruchu, śledzenie obiektów, planowanie ruchu | Uczenie nadzorowane, wzmacnianie, uczenie głębokie | CNN, LSTM, agenty wzmacniające |

| Przetwarzanie dokumentów | Klasyfikacja, parsowanie faktur, rozpoznawanie podmiotów | Uczenie nadzorowane, samonadzorowane, uczenie transferowe | LayoutLM, T5, BERT |

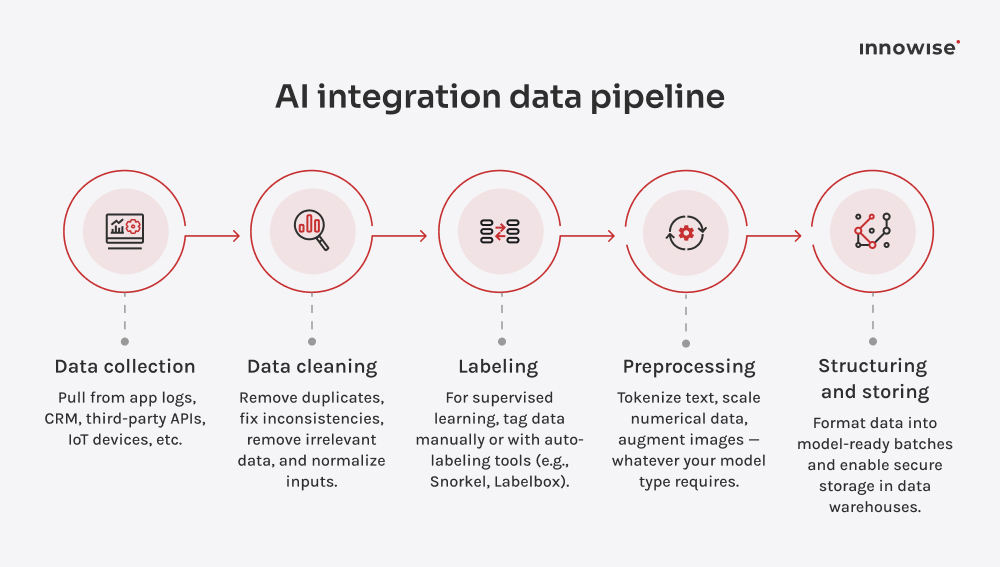

Dane są siłą napędową AI. Najlepiej traktować je jako ciągły proces. Najpierw upewniamy się, że aplikacja jest połączona z odpowiednimi źródłami danych - niezależnie od tego, czy są to dzienniki zachowań użytkowników, dane CRM czy dane wejściowe z czujników. Następnie sprawiamy, że jest to możliwe do wykorzystania.

Zawsze popieram uwzględnienie każdego kluczowego etapu potoku danych.

Na przykład w przypadku rozpoznawania mowy surowy dźwięk zostanie najpierw oczyszczony z szumów tła, a konserwacja predykcyjna wymaga synchronizacji danych wejściowych z różnych maszyn.

Aby nadążyć za tym procesem, należy stale go weryfikować i monitorować. Śledź jakość danych i ich dryfowanie w czasie, zwłaszcza w miarę ewolucji aplikacji lub zmian w jej środowisku.

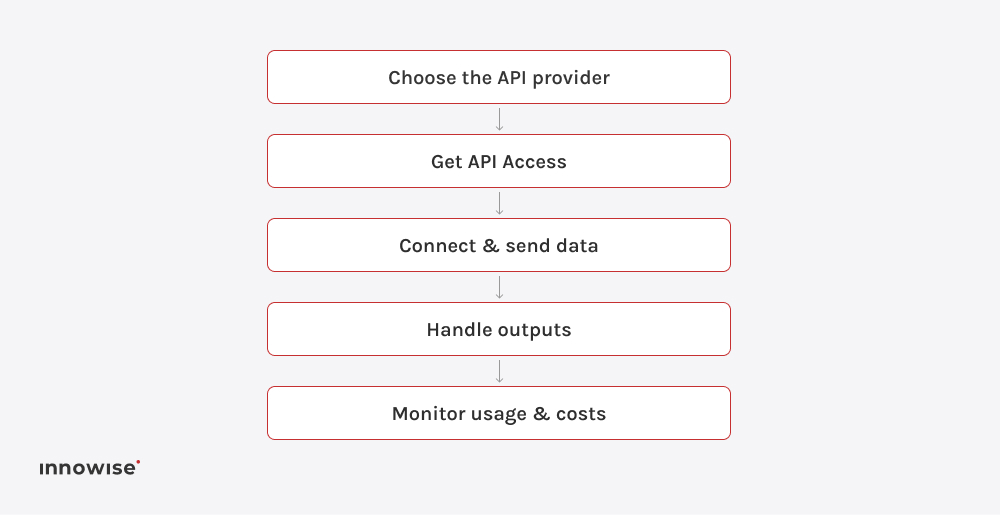

Badając sposób włączenia AI do aplikacji, należy pamiętać, że nie zawsze trzeba zaczynać od zera. W przypadku dobrze znanych przypadków użycia, wstępnie wytrenowane modele dostępne za pośrednictwem interfejsów API oferują szybką i opłacalną ścieżkę. Chcesz przeanalizować opinie klientów? Interfejs API języka naturalnego Google Cloud doskonale się do tego nadaje. Zamiana mowy na tekst w czasie rzeczywistym? Deepgram lub OpenAI Whisper mogą Ci w tym pomóc.

Modele te wykonują większość ciężkiej pracy, a przy odrobinie precyzji można je dostosować do kontekstu biznesowego.

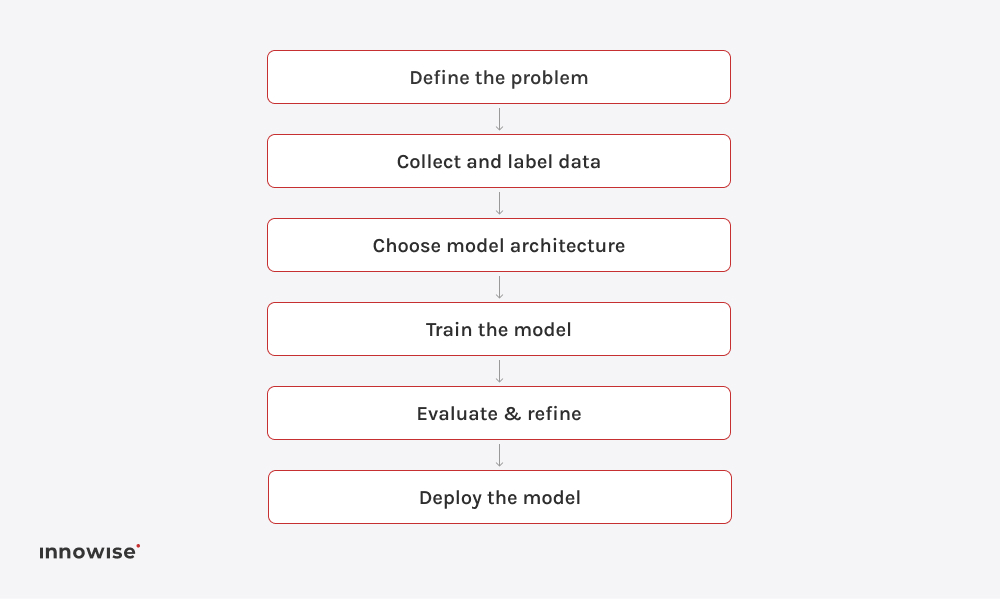

W przypadku bardzo specyficznych przypadków użycia, w których dokładność, skalowalność, bezpieczeństwo lub kontrola nie mogą być zagrożone, wybieramy inną ścieżkę: opracowywanie niestandardowych modeli. Pomyśl o wykrywaniu rzadkich usterek w maszynach przemysłowych, zasilaniu aplikacji obronnych lub sygnalizowaniu oszustw w systemach finansowych.

W takich przypadkach gotowe rozwiązania po prostu nie wystarczą, a my budujemy modele AI od podstaw. To dłuższa droga, ale gdy stawka jest wysoka, warto zrobić każdy krok.

Należy pamiętać, że backendy aplikacji AI są bardziej wymagające pod względem architektury, zwłaszcza pod względem wydajności i skalowalności w czasie rzeczywistym. Cloud działa najlepiej w większości scenariuszy opartych na AI, ale istnieją ważne wyjątki.

Wchodzimy na rynek lokalny, gdy obowiązują surowe przepisy lub wymagania dotyczące prywatności danych, takie jak obrazowanie medyczne lub analiza danych bankowych. Tworzymy architektury hybrydowe, aby zapewnić elastyczność i łatwość zarządzania AI, np. z przetwarzaniem danych logistycznych lub platformą SaaS, która dostarcza funkcje AI globalnie za pośrednictwem chmury, podczas gdy kluczowi klienci korporacyjni uruchamiają swoje modele prywatnie.

Nasze zespoły nie tworzą aplikacji samodzielnie. Tworzymy połączone środowiska AI, koncentrując się na tym, jak efektywnie dodać AI do aplikacji i projektując doświadczenia zorientowane na użytkownika zarówno na komputerach stacjonarnych, jak i na urządzeniach mobilnych rozwoju aplikacji mobilnych.

Myślisz, że możesz odetchnąć z ulgą po zakończeniu testów? Nie do końca. Tutaj wykraczamy poza podstawowe testowanie, ale pomagamy zbudować strukturę ciągłego testowania, która wspiera ewolucję modelu w czasie.

Zaczyna się od rygorystycznych wymagań testowych, ponieważ modele AI mogą z czasem ulec pogorszeniu. Najpierw sprawdzamy, czy uzyskuje on prawidłowe wyniki przez większość czasu i czy jest wystarczająco szybki do produkcji. Następnie testujemy przypadki brzegowe, takie jak rozpoznawanie twarzy przy słabym oświetleniu lub obsługa slangu w rozmowach z chatbotami. Sukces przyszedł, gdy testowanie stało się częścią pętli interakcji - uruchamiając ją wielokrotnie, dostosowując się do zmian.

Jak już wspomniałem, modelowanie AI to niekończąca się historia. Warto więc napisać mocną historię.

Po uruchomieniu modelu monitorujemy wydajność AI za pomocą pulpitów nawigacyjnych, takich jak Datadog, Prometheus lub niestandardowych analiz. Aby zapewnić ciągłość ulepszeń, oferujemy Usługi MLOps które umożliwiają testowanie A/B funkcji opartych na AI, zbierają informacje zwrotne od użytkowników w celu wykrycia fałszywych alarmów lub niepowodzeń oraz wspierają ponowne szkolenie przy użyciu świeżych danych, gdy zmienia się zachowanie użytkowników.

Jesteśmy tutaj, aby ponownie trenować modele, optymalizować szybkość wnioskowania i wprowadzać aktualizacje bez przerwy.

Oznacza to rejestrowanie wyników wnioskowania, wykrywanie dryftu danych lub koncepcji oraz konfigurowanie alertów dotyczących spadków wydajności lub anomalii - dzięki czemu AI jest ostry i gotowy do produkcji.

Pozwól, że uzbroję cię przed rozpoczęciem bitwy integracyjnej AI. Prawdziwi wrogowie pojawiają się późno, gdy zmiany stają się niemiłosiernie kosztowne. Kilka wskazówek, jak radzić sobie z nimi z dużym wyprzedzeniem.

Systemy AI często przetwarzają wrażliwe dane użytkowników, co sprawia, że zgodność z przepisami takimi jak RODO czy HIPAA ma krytyczne znaczenie. Aby zapewnić zgodność z przepisami, od samego początku wdrażamy projekty skoncentrowane na prywatności, stosując bezpieczne przechowywanie i szyfrowane potoki. Ograniczony dostęp ze ścieżkami audytu, anonimizacja i przejrzysta zgoda użytkownika to sprawdzone praktyki, których używamy w celu zwiększenia bezpieczeństwa. Nasz zespół zapewnia również ciągłą walidację i doskonalenie poprzez regularne przeglądy bezpieczeństwa.

Modele AI mogą nie działać, mieć halucynacje lub wykazywać tendencyjność wynikającą z danych treningowych. Kluczem jest zwiększenie różnorodności danych. Aby zrównoważyć dane szkoleniowe, wdrażamy testy dla przypadków skrajnych i różnorodności w świecie rzeczywistym, a nie tylko idealne scenariusze, i wykorzystujemy narzędzia wyjaśniające, a także odpowiedzialne podejście AI do zrozumienia decyzji. Ważne jest, aby nie wykluczać człowieka z pętli, pozostawiając mu strategiczne decyzje.

Problemy z kompatybilnością pojawiają się podczas łączenia AI z istniejącymi aplikacjami zbudowanymi na starszym stosie technologicznym lub usługami innych firm, które nie zostały zaprojektowane z myślą o AI. Aby zapobiec opóźnieniom lub wąskim gardłom wydajności, które mogą się pojawić, nasi eksperci wybierają architekturę mikrousług, aby odizolować funkcjonalność AI. Ponadto zalecamy wykorzystanie skalowalnych, natywnych środowisk chmurowych, takich jak AWS, GCP, Azure, opcjonalnie z obsługą GPU, utrzymywanie potoków wdrażania wersji i modeli do aktualizacji i wycofywania.

Unikamy budowania systemów AI jako ściśle powiązanych monolitów. Zamiast tego używamy modułowych wtyczek połączonych z istniejącą infrastrukturą za pomocą dobrze zdefiniowanych interfejsów. Dzięki temu każda część potoku AI może być rozwijana i testowana niezależnie, co zmniejsza ryzyko integracji i sprawia, że przyszłe aktualizacje są znacznie łatwiejsze w zarządzaniu.

Aby działało to w praktyce, tworzymy architekturę wokół takich komponentów jak:

Każdy z nich może być konteneryzowany i skalowany oddzielnie, co pozwala na szybszą iterację i bezpieczniejsze wdrożenia. Takie modułowe podejście buduje długoterminową odporność, ponieważ system AI ewoluuje wraz z nowymi danymi, przypadkami użycia lub wymaganiami biznesowymi.

Systemy AI trenują na znacznych, ale ograniczonych zbiorach danych, które zwykle różnią się od rzeczywistego świata. Dlatego aktualizacje i przekwalifikowanie, o których już wspomniałem, są niezbędne do utrzymania doskonałej wydajności.

Aby zmaksymalizować wydajność, zalecam traktowanie AI jak produktu. W Innowise pomagamy naszym klientom AI wyprzedzać konkurencję:

Granice AI wykraczają poza tradycyjne oprogramowanie, przecinając linie techniczne, etyczne, prawne i interfejsu użytkownika. Żaden pojedynczy zespół nie może "posiadać" AI od początku do końca. Współpraca pomaga zidentyfikować punkty zapalne dla wszystkich zaangażowanych stron i uniknąć kosztownych błędów wynikających z niedopasowania.

Oto jak Innowise napędza współpracę w projektach AI:

AI uwalnia czas i zasoby zespołu na to, co ważne. Powtarzalne, przewidywalne i wymagające dużej ilości danych zadania mogą być bez wysiłku obsługiwane przez AI, często nawet 10 razy szybciej niż w przypadku wykonywania ich ręcznie. Sprawdzają się one w przetwarzaniu dokumentów, obsłudze klienta, kontroli jakości i nie tylko. W rezultacie zespoły mogą skupić się na kreatywnej, strategicznej pracy na dużą skalę, podczas gdy rutynowe procesy są zautomatyzowane i wolne od błędów.

AI pobiera wszystkie dostępne dane, od zachowań klientów po procesy biznesowe i czynniki zewnętrzne. Gdy zidentyfikuje wzorce, może odkryć nawet drobne szczegóły, które okazują się kluczowe dla podejmowania decyzji. Jak to pomaga w prawdziwym życiu:

Wszystkie te krótkoterminowe wygrane, takie jak poprawa obsługi klienta i zautomatyzowane operacje, przygotowują grunt pod długoterminowy sukces, przy odpowiedniej strategii. Z czasem systemy stają się inteligentniejsze, decyzje trafniejsze, a usługi bardziej spersonalizowane. Z czasem przynosi to lepszą retencję klientów, niższe koszty operacyjne, przewagę konkurencyjną dzięki innowacjom szybszym niż rywale oraz większą odporność dzięki przewidywaniu ryzyka, wykrywaniu nieefektywności i zmniejszaniu zależności od reaktywnego zarządzania. To, co zaczęło się od rozwiązywania problemów, przekształca się w wizjonerski skok.

W Innowise zapewniamy kompleksowe usług rozwoju sztucznej inteligencji, - od doradztwa strategicznego po wdrożenie na pełną skalę. Dzięki 40 zrealizowanym projektom AI dobrze wiemy, gdzie zespoły zwykle utknęły, i pomagamy pominąć fazę prób i błędów.

Niezależnie od tego, czy chodzi o wizję komputerową, analitykę predykcyjną, inteligentną automatyzację, wykrywanie obecności czy inne, mamy udokumentowane doświadczenie w różnych technologiach, pomagając firmom osiągnąć wyniki, do których naprawdę dążą.

Łączymy wiedzę techniczną, zarządczą i domenową, aby upewnić się, że rozwiązanie AI jest zgodne z celami biznesowymi i środowiskiem. Tak, nie pozwalamy na uruchomienie AI dla samego AI, ale dostarczamy strategiczną mapę drogową z jasnymi technicznymi punktami odniesienia.

Nasz zespół zapewnia gotowe rozwiązania, które pomogą Ci osiągnąć zamierzony cel już za pierwszym razem. Możesz skontaktować się z nami w celu konsultacji, przejść przez audyty i rozpocząć podróż rozwojową w zakresie aplikacji, infrastruktury i stałego wsparcia.

Biorąc pod uwagę wydajność, koszt i złożoność AI, myślimy nieszablonowo, aby osiągnąć właściwą równowagę. W Innowise chronimy Cię przed skończeniem z systemem "Frankensteina". Zamiast tego otrzymujesz dobrze zaaranżowane rozwiązanie, w którym każdy element działa w harmonii.

Wiadomość została wysłana.

Przetworzymy Twoją prośbę i skontaktujemy się z Tobą tak szybko, jak to możliwe.

Rejestrując się, wyrażasz zgodę na naszą Polityką Prywatności, w tym korzystanie z plików cookie i przekazywanie Twoich danych osobowych.