Wiadomość została wysłana.

Przetworzymy Twoją prośbę i skontaktujemy się z Tobą tak szybko, jak to możliwe.

Formularz został pomyślnie przesłany.

Więcej informacji można znaleźć w skrzynce pocztowej.

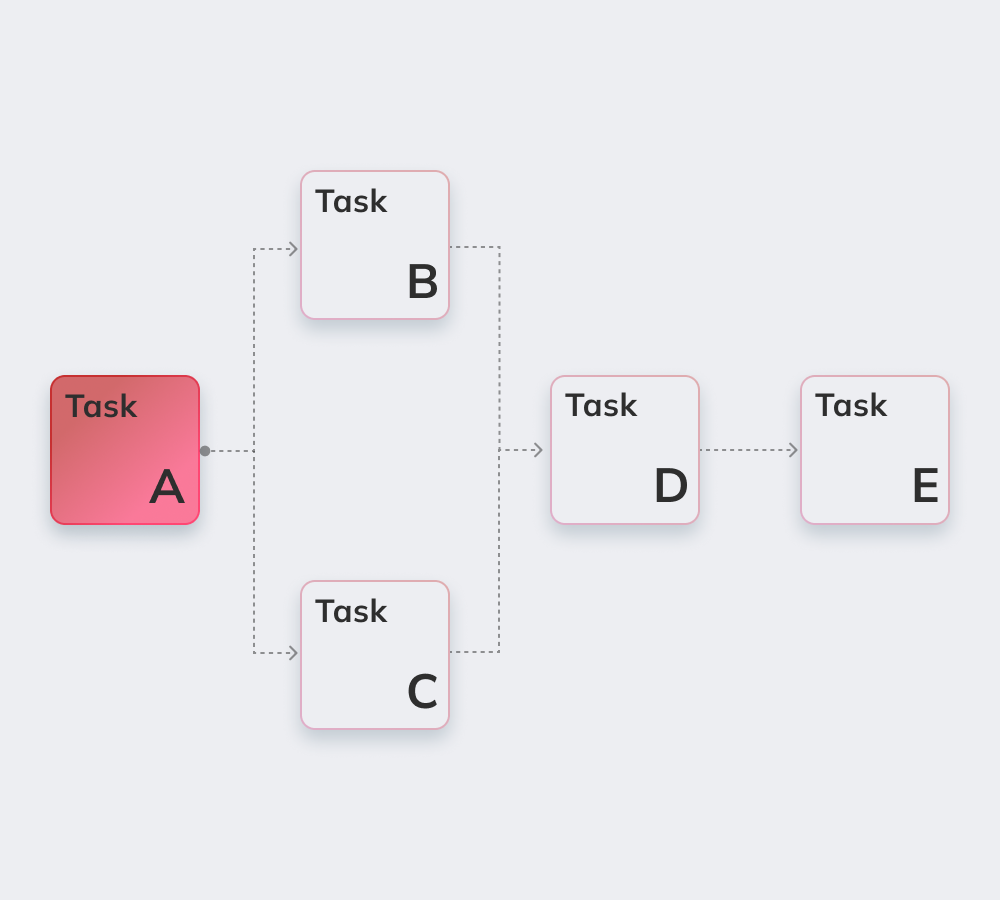

Apache Airflow to solidna, open-source'owa usługa napisana przez Python, używana przez inżynierów danych do orkiestracji przepływów pracy i potoków poprzez podświetlanie zależności potoków, kodu, dzienników, zadań wyzwalających, postępu i statusu sukcesu w celu rozwiązywania problemów w razie potrzeby.

Jeśli zadanie zostanie ukończone lub zakończy się niepowodzeniem, to elastyczne, skalowalne i kompatybilne z zewnętrznymi danymi rozwiązanie jest w stanie wysyłać alerty i wiadomości za pośrednictwem Slacka lub poczty e-mail. Apache nie nakłada ograniczeń na wygląd przepływu pracy i posiada przyjazny dla użytkownika interfejs do śledzenia i ponownego uruchamiania zadań.

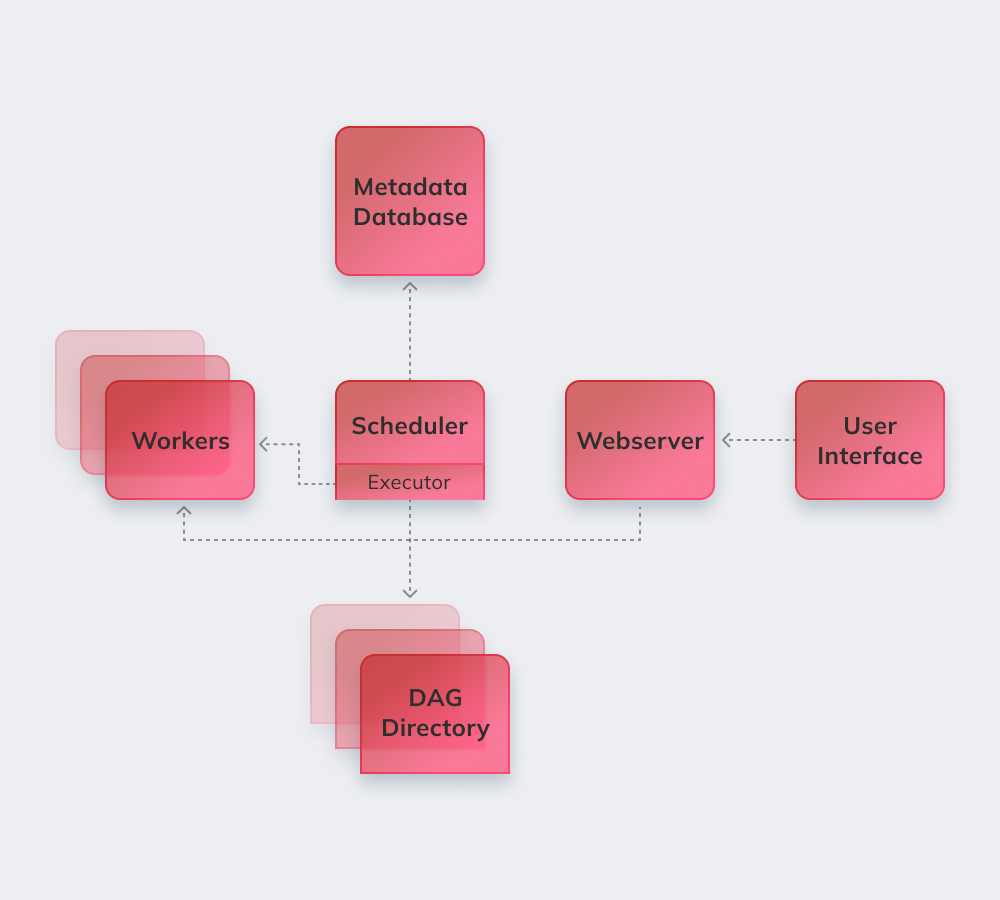

Na koniec, zobaczmy, jak Apache działa na prostym przykładzie. Po pierwsze, Apache przegląda wszystkie DAG-i w tle. Pilne zadania, które muszą zostać wykonane, otrzymują oznaczenie SCHEDULED w bazie danych. Scheduler pobiera zadania z bazy danych i rozdziela je do Executor'ów. Następnie zadania otrzymują status QUEUED, a gdy pracownicy zaczynają je wykonywać, przypisywany jest im status RUNNING. Po zakończeniu zadania pracownik wskazuje, czy zostało zakończone sukcesem czy porażką, a Scheduler aktualizuje status w bazie danych.

Poniżej przedstawiamy najbardziej ekscytujące funkcje Apache Airflow.

Podstawowa znajomość Python jest jedynym wymogiem do tworzenia rozwiązań na tej platformie.

Usługa jest bezpłatna i ma wielu aktywnych użytkowników na całym świecie.

Można bezproblemowo pracować z komplementarnymi produktami Microsoft Azure, Google Cloud Platform, Amazon AWS itp.

Status zaplanowanych i trwających zadań można śledzić w czasie rzeczywistym.

Poznaj podstawowe zasady Apache Airflow poniżej.

Rurociągi przepływu powietrza są skonfigurowane jako kod Python, aby generowanie pipeline'ów było dynamiczne.

Użytkownicy mogą tworzyć zdefiniowanych operatorów, executor'ów i biblioteki, dostosowane do specyficznego środowiska biznesowego.

Usługa nie zawiesza się, ponieważ ma modularną architekturę i może być skalowana w nieskończoność.

Obejmują one automatyzację, społeczność, wizualizację procesów biznesowych, a także odpowiednie monitorowanie i kontrolę. Pokrótce omówimy je wszystkie.

Jest ponad 1000 współtwórców open-source'owej usługi. Regularnie uczestniczą w jej rozwoju.

Apache to idealne narzędzie do generowania „większego obrazu” systemu zarządzania przepływem pracy.

Automatyzacja usprawnia pracę inżynierów danych i zwiększa ogólną wydajność.

Wbudowany system alertów i powiadomień umożliwia ustalanie obowiązków i wdrażanie poprawek.

Wiele platform inżynierii danych opartych na Airflow wykorzystuje podstawową logikę i zalety usługi oraz dodaje nowe funkcje w celu rozwiązania konkretnych wyzwań. Można je nazwać alternatywami Apache Airflow, ponieważ mają dość podobną funkcjonalność:

Amazon Managed Workflows for Apache Airflow - zarządzana usługa orkiestracji przepływu pracy Airflow do konfigurowania i obsługi potoków danych w Amazon Web Services (AWS).

Apache to potężne narzędzie do inżynierii danych kompatybilne z usługami i platformami innych firm. Migracja do Airflow jest płynna i bezproblemowa niezależnie od wielkości i specyfikacji firmy.

Innowise zapewnia dogłębną ekspertyzę Apache o dowolnej złożoności i zakresie. Apache Airflow to doskonały wybór, aby zaprowadzić porządek, jeśli klient cierpi z powodu słabej komunikacji między działami i szuka większej przejrzystości w przepływie pracy.

Nasi wykwalifikowani programiści wdrożą wysoce dostosowany system modularny, który poprawia operacje z dużymi danymi i sprawia, że procesy Airflow są w pełni zarządzane i dostosowane do specyfiki Twojego środowiska biznesowego.

Oceń ten artykuł:

4.8/5 (45 opinii)

Wiadomość została wysłana.

Przetworzymy Twoją prośbę i skontaktujemy się z Tobą tak szybko, jak to możliwe.

Rejestrując się, wyrażasz zgodę na naszą Polityką Prywatności, w tym korzystanie z plików cookie i przekazywanie Twoich danych osobowych.