Votre message a été envoyé.

Nous traiterons votre demande et vous contacterons dès que possible.

Le formulaire a été soumis avec succès.

Vous trouverez de plus amples informations dans votre boîte aux lettres.

Sélection de la langue

Apache Airflowest un service robuste, open-source, écrit en Python, utilisé par Data Engineers pour orchestrer les workflows et les pipelines en mettant en évidence les dépendances, le code, les journaux, les tâches de déclenchement, la progression et l'état de réussite des pipelines afin de résoudre les problèmes si nécessaire.

Si la tâche s'achève ou échoue, cette solution flexible, évolutive et compatible avec les données externes est capable d'envoyer des alertes et des messages via Slack ou par courriel. Apache n'impose pas de restrictions sur l'aspect du flux de travail et dispose d'une interface conviviale pour suivre et réexécuter les tâches.

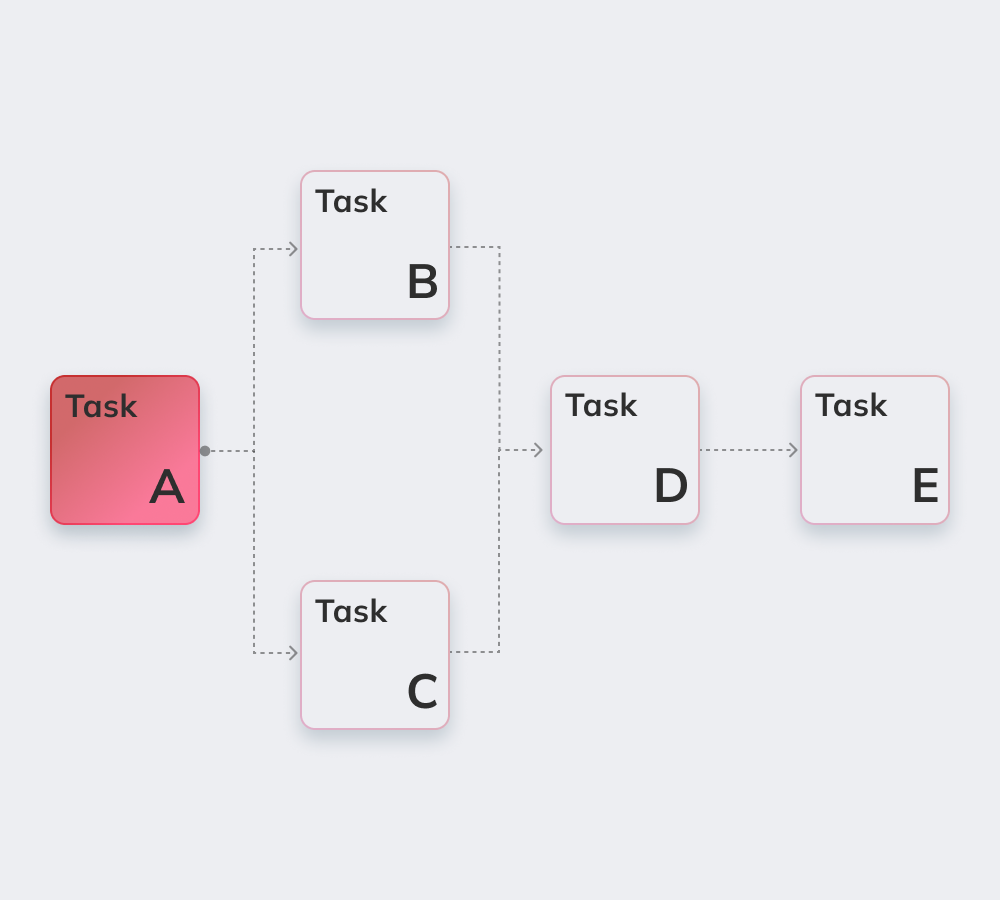

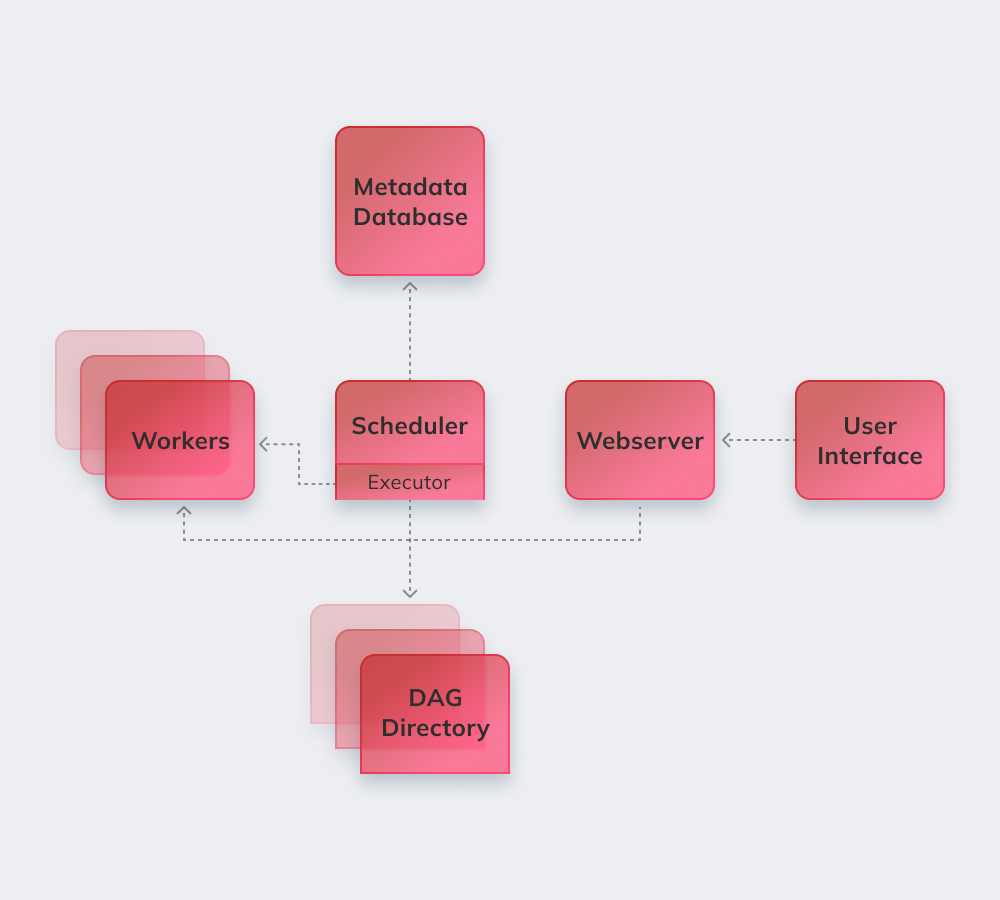

Enfin, démontrons comment Apache fonctionne sur un exemple simple. Tout d'abord, Apache révise tous les DAGs en arrière-plan. Les tâches urgentes qui doivent être achevées reçoivent la marque SCHEDULED dans la base de données. Le Scheduler récupère les tâches dans la base de données et les distribue aux Executors. Ensuite, les tâches reçoivent le statut QUEUED, et lorsque les travailleurs commencent à les exécuter, le statut RUNNING est attribué à la tâche. Lorsque la tâche est terminée, le travailleur l'indique comme terminée/échec en fonction du succès du résultat final, et le Scheduler met à jour le statut dans la base de données.

Ci-dessous, nous énumérons les caractéristiques les plus intéressantes d'Apache Airflow.

Une connaissance de base de Python est la seule exigence pour construire des solutions sur la plateforme.

Le service est gratuit et compte de nombreux utilisateurs actifs dans le monde entier.

Il est possible de travailler en toute transparence avec des produits complémentaires de Microsoft AzureGoogle Cloud Platform, Amazon AWS, etc.

Vous pouvez suivre en temps réel l'état des tâches programmées et en cours.

Découvrez ci-dessous les principes de base d'Apache Airflow.

Les pipelines de flux d'air sont configurés comme Code Python pour rendre dynamique la génération des pipelines.

Les utilisateurs peuvent créer des opérateurs, des exécutants et des bibliothèques définis, adaptés à leur environnement professionnel spécifique.

Le service ne tombe pas en panne car il possède une architecture modulaire et peut être étendu à l'infini.

Ils comprennent l'automatisation, la communauté, la visualisation des processus d'affaires, ainsi qu'un suivi et un contrôle appropriés. Nous allons les passer en revue brièvement.

Il y a plus de 1000 contributeurs au service open-source. Ils participent régulièrement à sa mise à jour.

Apache est un outil parfait pour obtenir une "vue d'ensemble" de son système de gestion des flux de travail.

L'automatisation facilite le travail des ingénieurs en données et améliore les performances globales.

Le système intégré d'alertes et de notifications permet de définir les responsabilités et de mettre en œuvre les corrections.

De nombreuses plateformes d'ingénierie de données utilisant Airflow utilisent la logique de base et les avantages du service et ajoutent de nouvelles fonctionnalités pour résoudre des problèmes spécifiques. Elles peuvent être appelées Apache Airflow alternatives puisqu'elles ont des fonctionnalités assez similaires:

Amazon Managed Workflows for Apache Airflow - un service géré d'orchestration de flux de travail Airflow pour mettre en place et exploiter des pipelines de données sur Amazon Web Services (AWS).

Apache est un outil puissant d'ingénierie des données compatible avec des services et des plates-formes tiers. La migration vers Airflow se fait en douceur et sans problème, quelles que soient la taille et les spécifications de l'entreprise.

Le groupe Innowise offre une expertise approfondie d'Apache, quelle que soit la complexité et l'ampleur de la tâche. Apache Airflow est un choix idéal pour remettre de l'ordre si un client souffre d'une mauvaise communication entre les départements et recherche une plus grande transparence dans les flux de travail.

Nos développeurs qualifiés mettront en œuvre un système modulaire hautement personnalisé qui améliorera le fonctionnement grâce au big data et permettra aux processus d'Airflow d'être entièrement gérés et de s'adapter aux besoins des clients. adaptable aux particularités de votre environnement professionnel.

Notez cet article :

4.8/5 (45 commentaires)

Votre message a été envoyé.

Nous traiterons votre demande et vous contacterons dès que possible.

En vous inscrivant, vous acceptez notre Politique de confidentialitéy compris l'utilisation de cookies et le transfert de vos informations personnelles.