Su mensaje ha sido enviado.

Procesaremos su solicitud y nos pondremos en contacto con usted lo antes posible.

El formulario se ha enviado correctamente.

Encontrará más información en su buzón.

Seleccionar idioma

Apache Airflowes un servicio robusto, de código abierto y escrito en Python utilizado por Ingenieros de datos para orquestar flujos de trabajo y pipelines resaltando las dependencias de los pipelines, el código, los registros, las tareas de activación, el progreso y el estado de éxito para solucionar problemas cuando sea necesario.

Si la tarea se completa o falla, esta solución flexible, escalable y compatible con datos externos es capaz de enviar alertas y mensajes a través de Slack o correo electrónico. Apache no impone restricciones sobre el aspecto que debe tener el flujo de trabajo y cuenta con una interfaz fácil de usar para realizar el seguimiento y volver a ejecutar los trabajos.

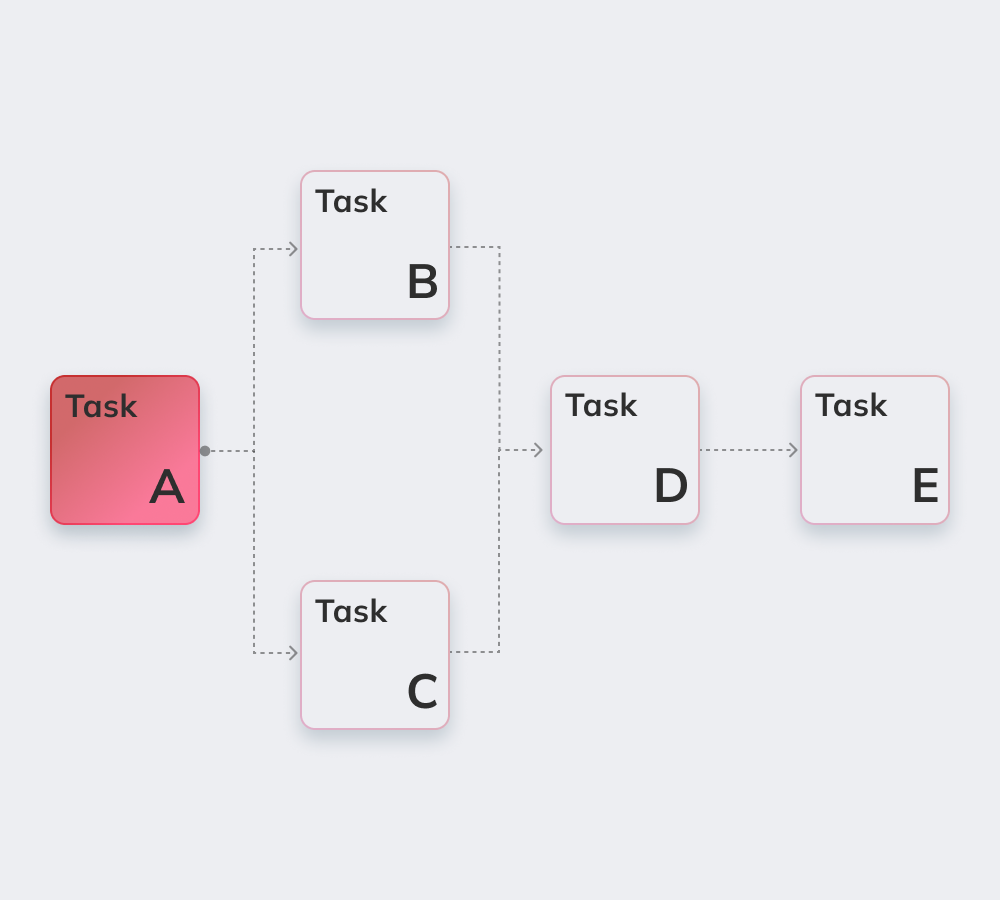

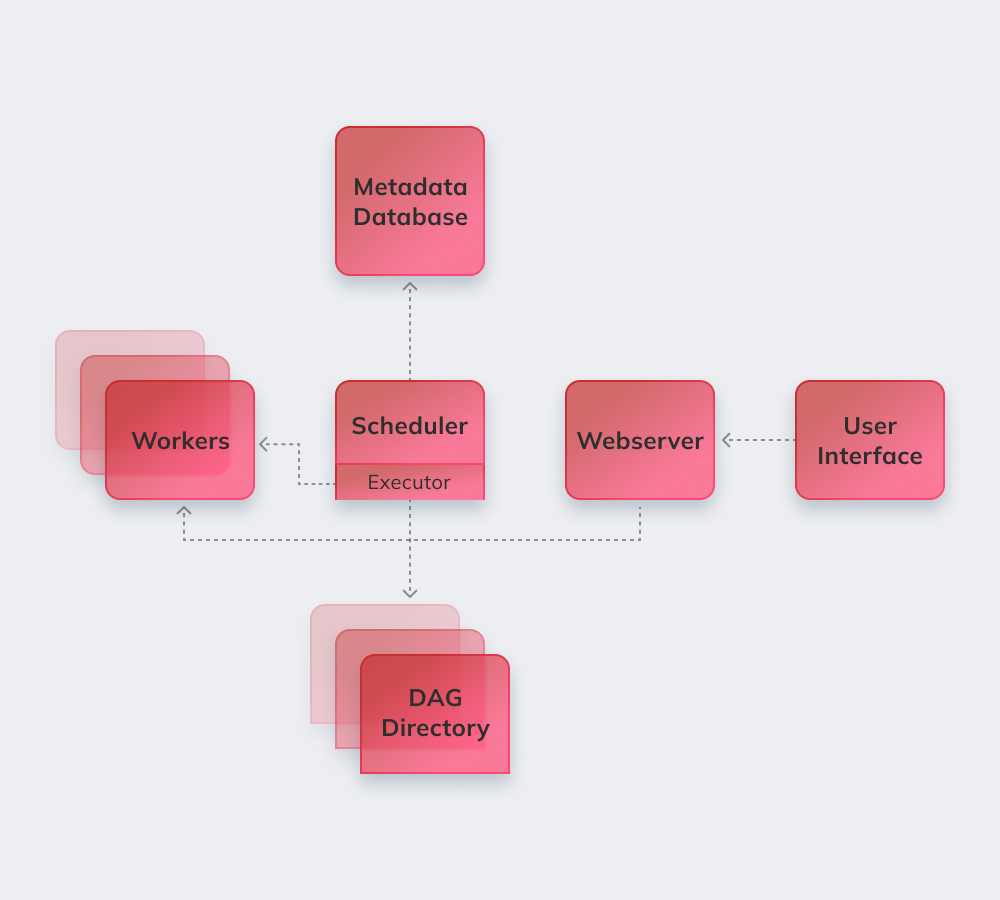

Por último, vamos a demostrar cómo funciona Apache con un ejemplo sencillo. En primer lugar, Apache revisa todos los DAGs en segundo plano. Las tareas urgentes que necesitan ser completadas obtienen la marca SCHEDULED en la base de datos. El Planificador recupera las tareas de la base de datos y las distribuye a los Ejecutores. Después, las tareas reciben el estado QUEUED, y una vez que los trabajadores empiezan a ejecutarlas, se asigna el estado RUNNING a la tarea. Cuando se completa la tarea, el trabajador la indica como finalizada/fallida en función del éxito del resultado final, y el Planificador actualiza el estado en la base de datos.

A continuación, enumeramos las características más interesantes de Apache Airflow.

Un conocimiento básico de Python es el único requisito para construir soluciones en la plataforma.

El servicio es gratuito y cuenta con muchos usuarios activos en todo el mundo.

Se puede trabajar sin problemas con productos complementarios de Microsoft Azure, Google Cloud Platform, Amazon AWS, etc.

Puede seguir el estado de las tareas programadas y en curso en tiempo real.

Conozca a continuación los principios básicos de Apache Airflow.

Los conductos de aire se configuran como Código Python para dinamizar la generación de tuberías.

Los usuarios pueden crear operadores, ejecutores y bibliotecas definidos y adecuados para su entorno empresarial específico.

El servicio no se bloquea porque tiene una arquitectura modular y puede ampliarse hasta el infinito.

Incluyen la automatización, la comunidad, la visualización de los procesos empresariales, así como la supervisión y el control adecuados. Vamos a repasar brevemente todos ellos.

Este servicio de código abierto cuenta con más de 1.000 colaboradores. Participan regularmente en su actualización.

Apache es una herramienta perfecta para generar una "imagen más amplia" del propio sistema de gestión del flujo de trabajo.

La automatización facilita el trabajo de los ingenieros de datos y mejora el rendimiento general.

El sistema integrado de alertas y notificaciones permite establecer responsabilidades y aplicar correcciones.

Un montón de plataformas de ingeniería de datos potenciadas por Airflow utilizan la lógica básica y los beneficios del servicio y añaden nuevas características para resolver retos específicos. Se les puede llamar alternativas Apache Airflow, ya que tienen una funcionalidad bastante similar:

Amazon Managed Workflows para Apache Airflow: un servicio de orquestación de flujos de trabajo Airflow administrado para configurar y operar canalizaciones de datos en Amazon Web Services (AWS).

Apache es una potente herramienta de ingeniería de datos compatible con servicios y plataformas de terceros. La migración a Airflow es fluida y sin problemas, independientemente del tamaño y las especificaciones de la empresa.

Innowise ofrece una profunda experiencia en Apache de cualquier complejidad y alcance. Apache Airflow es una opción perfecta para poner orden si un cliente sufre de mala comunicación entre departamentos y busca más transparencia en los flujos de trabajo.

Nuestros cualificados desarrolladores implementarán un sistema modular altamente personalizado que mejore el funcionamiento con big data y haga que los procesos de Airflow estén totalmente gestionados y adaptable a las peculiaridades de su entorno empresarial.

Valora este artículo:

4,8/5 (45 opiniones)

Su mensaje ha sido enviado.

Procesaremos su solicitud y nos pondremos en contacto con usted lo antes posible.

Al registrarse, acepta nuestra Política de privacidadincluyendo el uso de cookies y la transferencia de su información personal.