Wiadomość została wysłana.

Przetworzymy Twoją prośbę i skontaktujemy się z Tobą tak szybko, jak to możliwe.

Formularz został pomyślnie przesłany.

Więcej informacji można znaleźć w skrzynce pocztowej.

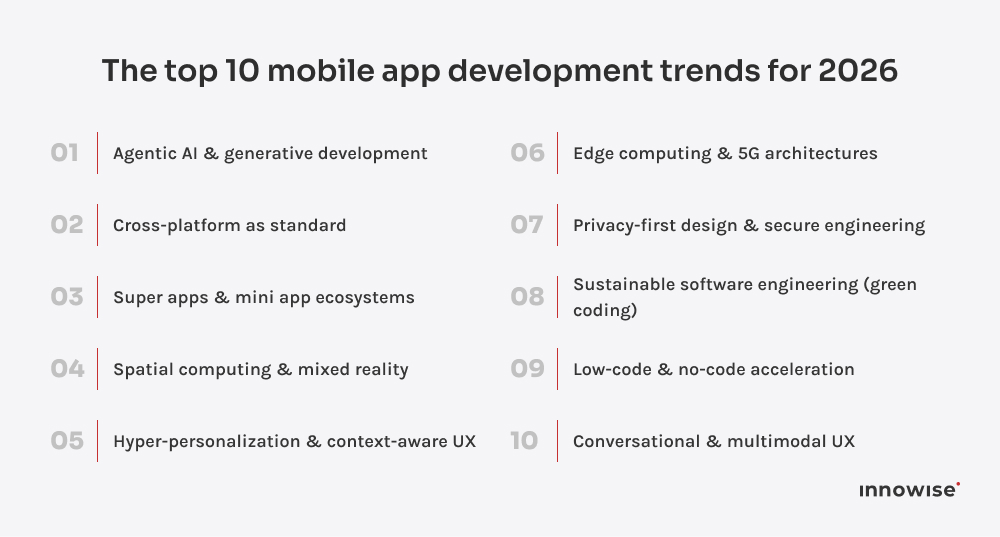

Wykorzystanie Aktualne trendy w tworzeniu aplikacji mobilnych pokazują wyraźny wzorzec: zespoły budują szybciej, mądrzej i z większym naciskiem na doświadczenie. 2026 to rok udoskonalania: czystszych przepływów pracy, większej automatyzacji i narzędzi, które w końcu nadążają za instynktami programistów. Oto dziesięć obszarów, w których obecnie dokonuje się prawdziwy postęp.

Pierwszy na liście Najważniejsze trendy w tworzeniu aplikacji mobilnych to oczywiście agenci AI. Każdy poważny zespół mobilny pracuje teraz z co najmniej jednym agentem AI. Czyta on repozytorium, naprawia zależności, zanim się spiętrzą, i utrzymuje bazy kodu Kotlin, Swift i Flutter wyrównane i spójne. Konfiguracja jest płynna: czyste zatwierdzenia, brak chaosu w ostatniej chwili, wszystko śledzone i wyrównane.

Przepływy pracy od projektu do kodu wreszcie są cywilizowane. Po upuszczeniu linku Figma lub wyeksportowanego layoutu, agent tworzy szkic layoutu, mapuje go do biblioteki komponentów i wysyła gałąź gotową do recenzji. Raporty CI/CD trafiają prosto do Slacka. Nikt nie czeka na kompilacje ani nie przekopuje się przez dzienniki błędów.

Telemetria to miejsce, w którym robi się zabawnie. System AI analizuje dane na żywo, wykrywa klastry awarii i wskazuje bezpośrednio na commit, który je spowodował. To jak posiadanie obsesyjnego debuggera, który nigdy nie śpi i naprawdę to lubi.

Efekt w zespołach jest stały i przewidywalny: szybsze cykle, mniej regresji, spokojniejsi deweloperzy. Szczegóły McKinsey Wymierna poprawa produktywności dzięki narzędziom opartym na genAI w tworzeniu oprogramowania. Śmiem twierdzić, że agentic AI jest teraz mniej trendem, a bardziej kręgosłupem nowoczesnego rozwoju mobilnego.

Kiedy słyszysz “jedna baza kodu dla iOS i Android” brzmi nie tylko wydajnie. To są skuteczny. W 2026, Zespoły mobilne angażują się we frameworki takie jak Flutter, React Native i Kotlin Multiplatform, ponieważ są to mądre inwestycje. Według Najnowocześniejszy przegląd w 2025 r., W ostatnich latach rozwój wieloplatformowych aplikacji mobilnych osiągnął już znaczącą popularność wśród deweloperów, społeczności i na rynku pracy.

I tak, kompromisy w zakresie wydajności nadal istnieją, ale zmniejszają się z każdym wydaniem frameworków. Obsługa wielu urządzeń i wielu ekranów szybko staje się podstawowym oczekiwaniem, a zespoły planują architektury, które skalują się na telefonach, tabletach, urządzeniach do noszenia, komputerach stacjonarnych, a nawet systemach samochodowych.

W skrócie: jeśli twój mobilny plan działania obejmuje skalowanie na różnych platformach, docieranie do większych segmentów użytkowników i utrzymanie rozsądnego budżetu deweloperskiego, rozwój międzyplatformowy nie jest opcjonalny.

Wszyscy mówili o superaplikacjach jak o “fenomenie rynku azjatyckiego”. Ta era już minęła. W 2026, Zachodnie technologie w końcu nadrabiają zaległości. Zamiast prostego łączenia produktów, firmy łączą ze sobą usługi z różnych dziedzin, które nigdy wcześniej nie były dostępne pod jednym dachem. Pomyślmy o platformach do przesyłania wiadomości z wbudowanymi płatnościami, kanałach społecznościowych, które pełnią funkcję rynków, lub aplikacjach mobilnych, które obsługują również dostawy żywności, bilety na wydarzenia i ubezpieczenia. Wszystko znajduje się teraz w jednej aplikacji.

Prawdziwa historia tkwi w infrastrukturze. Nowoczesne superaplikacje uruchamiają modułowe mikro-frontendy zszyte ze sobą za pomocą bezpiecznych interfejsów API i kolejek komunikatów. Każda “mini aplikacja” działa niezależnie, ale platforma nadrzędna kontroluje warstwy uwierzytelniania, danych i płatności. Struktura ta przypomina bardziej lekki system operacyjny niż pojedynczy produkt.

Ta konfiguracja rozwiązuje ból głowy, który większość liderów produktu dobrze zna: rozrost funkcji. Zamiast utrzymywać sześć odłączonych aplikacji, zespoły rozszerzają jeden ekosystem. Nowa usługa pojawia się jako mikromoduł z własnym cyklem wydawniczym i strumieniem analitycznym. Użytkownicy doświadczają ciągłości, a deweloperzy dostarczają produkty szybciej i z mniejszym ryzykiem zepsucia wszystkiego innego.

Wyniki biznesowe skalują się odpowiednio. Zaangażowanie rośnie, ponieważ użytkownicy dłużej pozostają w tym samym ekosystemie. Opcje monetyzacji mnożą się, a sprzedaż krzyżowa staje się płynna, gdy płatności, wiadomości i odkrywanie już działają w tym samym interfejsie. Model ten otwiera również partnerstwa white-label: miniaplikacje innych firm można zintegrować z istniejącymi platformami bez ponoszenia wysokich kosztów integracji.

Jak podaje Statista, WeChat przeszedł 1,3 miliarda aktywnych użytkowników do 2024 r., a zachodnie ekosystemy szybko uczą się z tego podręcznika. Instytucje finansowe, sprzedawcy detaliczni i operatorzy telekomunikacyjni prowadzą obecnie wewnętrzne programy pilotażowe dla “struktur mini aplikacji”, które naśladują ten sam model: natywny poziom UX, niezależne wdrożenia, ujednolicone zarządzanie danymi.

Dla zespołów planujących 2026 superaplikacje są mniej trendem, a bardziej strategią przetrwania. Użytkownicy oczekują wygody, a platformy, które ją zapewniają, stają się ekosystemami zamiast aplikacjami.

Deweloperzy wreszcie mogą tworzyć dla świata, który wykracza poza ekran. Obliczenia przestrzenne znajdują się teraz w centrum poważnych mobilnych map drogowych jako kolejna warstwa interfejsu użytkownika.

Sprzęt nie jest jeszcze w pełni dostępny, ale jest coraz bliżej. Apple Vision Pro, Meta Quest 3 i fala dość lekkich okularów AR umożliwiają eksperymentowanie z AR. Interfejsy immersyjne, Nawet jeśli doświadczenie to wciąż wydaje się nieco wczesne i niszowe. Zamiast przepisywać wszystko od zera, deweloperzy mogą teraz ponownie wykorzystywać dużą część swojej mobilnej logiki i zasobów na różnych urządzeniach dzięki współdzielonym zestawom SDK i narzędziom międzyplatformowym. Nawet jeśli większość zestawów słuchawkowych AR nadal działa jako samodzielne systemy.

Dla zespołów mobilnych zmienia to całą logikę projektowania. Interfejs przestaje żyć w pikselach i zaczyna żyć w przestrzeni. Pomyśl o pulpitach nawigacyjnych przypiętych do biurka użytkownika, nawigacji w czasie rzeczywistym nałożonej na ulice, zdalnych przewodnikach konserwacyjnych, które łączą wideo, modele 3D i narrację AI. React Native AR, Unity MARS i Apple RealityKit 2 obsługują teraz te warstwy z rzeczywistą stabilnością produkcji. Nie są wymagane żadne eksperymentalne flagi.

Doświadczenia przestrzenne zmieniają również sposób, w jaki zespoły testują i mierzą UX. Śledzenie wzroku, przechwytywanie gestów i mapowanie głębi w czasie rzeczywistym dają projektantom produktów nowe wskaźniki do optymalizacji zaangażowania. Ten sam stos analityczny, który kiedyś śledził dotknięcia ekranu, teraz mierzy wektory uwagi i czas interakcji z obiektami.

Branże na pierwszym miejscu? Opieka zdrowotna, logistyka i edukacja. Symulacje szkoleniowe i zdalna diagnostyka już teraz zapewniają wymierny zwrot z inwestycji. A Raport PwC na temat technologii immersyjnych szacuje wzrost produktywności o ponad 26% dla ról terenowych i technicznych, gdy przepływy pracy kierowane przez AR zastępują tradycyjne instrukcje.

Dla deweloperów mobilnych przetwarzanie przestrzenne jest jak odkrywanie większego płótna. Aplikacje nie konkurują już o miejsce na ekranie; konkurują o obecność.

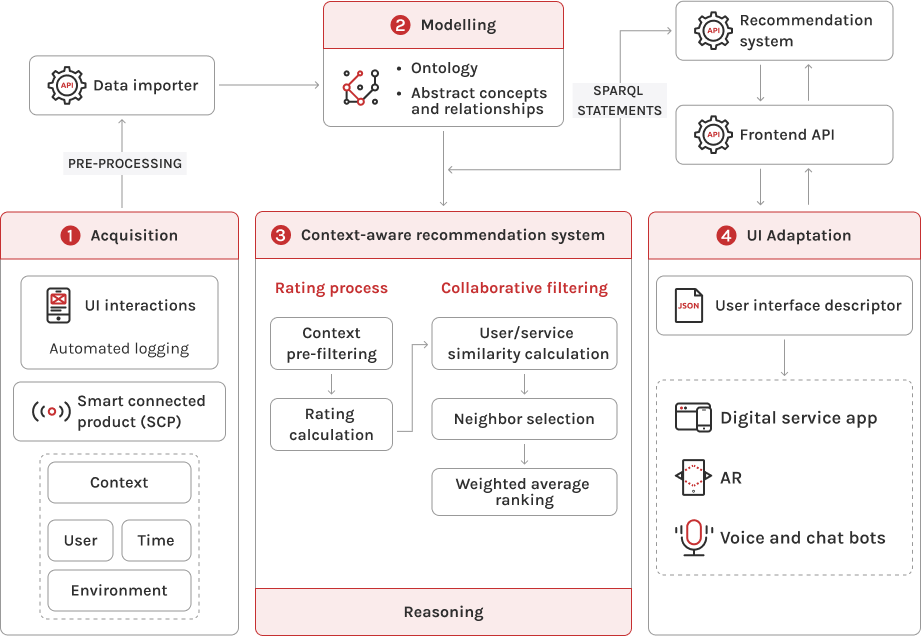

Personalizacja oznaczała kiedyś “użytkownicy widzą różne banery”. W 2026, Oznacza to, że aplikacja zmienia się sama. Układy, nawigacja, czas, a nawet mikrokopia - wszystko dostosowuje się do tego, co robi użytkownik, gdzie się znajduje i co dzieje się wokół niego.

Wszystko zależy od kontekstu. Czujniki ruchu, geolokalizacja i dane z kalendarza zasilają modele, które na bieżąco dostosowują zachowanie aplikacji. Aplikacja finansowa zauważa, że jesteś w innym kraju i oferuje wgląd w walutę, zanim otworzysz konwerter. Aplikacja wellness odczytuje dane tętna i przyciemnia interfejs, gdy puls wzrasta. To personalizacja odczucie.

Pod maską zmiana wynika z lekkich modeli na urządzeniu. Zamiast wnioskowania w chmurze, inteligencja działa lokalnie. Szybciej, prywatniej i oszczędniej dla baterii. Zarówno frameworki Androida, jak i iOS (Core ML, Android ML Kit) obsługują teraz wnioskowanie kontekstowe w czasie rzeczywistym bez wywołań serwera, więc personalizacja nie zamienia wydajności na prywatność.

Zmienia się również proces projektowania. Zamiast statycznych podróży użytkowników, zespoły budują stany adaptacyjne: Logikę UX “jeśli/wtedy”, która reaguje na intencje. To po części psychologia, po części inżynieria. Prawidłowo wykonane interfejsy kontekstowe po cichu usuwają tarcia: mniej kliknięć, lepsze wyczucie czasu, większa trafność.

Dla firm jest to matematyka retencji. Użytkownicy pozostają, gdy produkt jest do nich dopasowany. Raport "Connected Customer 2024" firmy Salesforce pokazuje, że 61% klientów oczekuje, że firmy będą przewidywać ich potrzeby, a większość z nich odejdzie, gdy interakcje nie dostosują się do ich kontekstu.

Najmądrzejsze zespoły prototypują teraz te adaptacyjne przepływy bezpośrednio w Figma przy użyciu wtyczek AI, które symulują zmienne środowiskowe: ruch, wskazówki dotyczące lokalizacji, nawyki związane z porą dnia, a nawet przewidywane zamiary. Rezultatem jest nowa dyscyplina projektowania: taka, która traktuje UX jako żywy system, a nie stały układ.

Krótko mówiąc, statyczne interfejsy należą do przeszłości. Kontekst wygrywa, ponieważ szacunki uwaga.

Jeśli jest jedna rzecz, której deweloperzy nienawidzą, to czekanie, aż chmura nadrobi zaległości. W tym miejscu przetwarzanie brzegowe po cichu zmienia zasady gry. W 2026, Czas rzeczywisty jest stawką, a to jest możliwe tylko wtedy, gdy aplikacje przetwarzają dane bliżej użytkownika.

Pomysł jest prosty: przestać wysyłać wszystko na drugą stronę planety. Zamiast tego należy przenieść zadania obliczeniowe do węzłów brzegowych: stacji bazowych 5G, lokalnych bramek, a nawet samego urządzenia użytkownika. Rezultat? Mniejsze opóźnienia, płynniejsze przesyłanie strumieniowe i znacznie mniejsze zużycie baterii.

To, co kiedyś wymagało ciężkiej infrastruktury chmurowej, teraz działa w milisekundach. Aplikacje logistyczne śledzą floty na żywo bez opóźnień. Aplikacje AR renderują ruch z prędkością 90 klatek na sekundę bez choroby lokomocyjnej. Przemysłowe pulpity nawigacyjne IoT uruchamiają analizy predykcyjne bezpośrednio z czujników terenowych, zamiast czekać w chmurze.

Jak podaje Statista, Oczekuje się, że globalny rynek edge computing osiągnie poziom $317 mld euro do 2026 r., rosnąc w tempie ponad 18% CAGR. To już nie jest nisza. To nowy kręgosłup wydajności mobilnej.

5G znajduje się tuż nad nim. Sieci o bardzo niskich opóźnieniach (zaledwie 1 ms) odblokowują takie funkcje, jak natychmiastowe granie w chmurze, tłumaczenie w czasie rzeczywistym i połączenia wideo z wieloma kamerami, które kiedyś były fantastyczne w czasach 4G. Deweloperzy projektują teraz aplikacje w oparciu o zasady “edge-native”, utrzymując krytyczną logikę blisko urządzenia, jednocześnie synchronizując długoterminowe dane z chmurą asynchronicznie.

To architektura, która jest niewidoczna dla użytkowników, ale zmienia wydajność. Aplikacje otwierają się szybciej, strumieniują płynniej i pozostają bardziej niezawodne w strefach słabej łączności. To przewaga konkurencyjna w najbardziej dosłownym tego słowa znaczeniu.

Bądźmy szczerzy: użytkownicy mają problemy z zaufaniem i nie bez powodu. Każda aplikacja chce danych; niewiele z nich wyjaśnia, co się z nimi dzieje. W 2026, Projektowanie zorientowane na prywatność przestało być polem wyboru zgodności i stało się kluczową częścią strategii produktu.

Deweloperzy wprowadzają teraz zabezpieczenia do kompilacji, a nie łatają je później. Architektury zerowego zaufania i modele chroniące prywatność są standardem w poważnych projektach mobilnych. Oznacza to brak powszechnego dostępu do interfejsów API, brak współdzielonych tokenów między usługami i brak planów typu “zaszyfrujemy to później”.

Nowoczesne stosy opierają się na bezpieczne enklawy, prywatność różnicowa, i nauka federacyjna aby zachować lokalne dane, jednocześnie szkoląc inteligentniejsze systemy. Na przykład Apple Przekaźnik prywatny i Google Piaskownica prywatności Oba nadają ton: zachowaj anonimowość identyfikatorów, utrzymuj obliczenia na urządzeniu i nadal dostarczaj ukierunkowaną funkcjonalność.

DEX Raport Gartnera z 2025 r. wymienił “obliczenia zwiększające prywatność” wśród 10 najważniejszych trendów w zakresie bezpieczeństwa w przedsiębiorstwach, które szybko przeniosły się na rozwój urządzeń mobilnych. Zespoły osadzają te koncepcje bezpośrednio w zestawach SDK i przepływach pracy CI/CD:

Ale bezpieczeństwo wykracza teraz poza kod. Ważną rolę odgrywa również projektowanie UX. Przejrzyste przepływy zgody, kontekstowe monity o zgodę i przejrzyste pulpity nawigacyjne dotyczące wykorzystania danych stały się produktami UX. Użytkownicy pozostają dłużej, gdy ufają temu, co dzieje się za kulisami.

Dla zespołów mobilnych zaufanie to przekłada się na ochronę przychodów. Pojedyncza katastrofa PR związana z wyciekiem danych może zniweczyć miesiące wydatków na akwizycję. Aplikacje dbające o prywatność nie tylko pozostają zgodne z przepisami, ale także są pożądane.

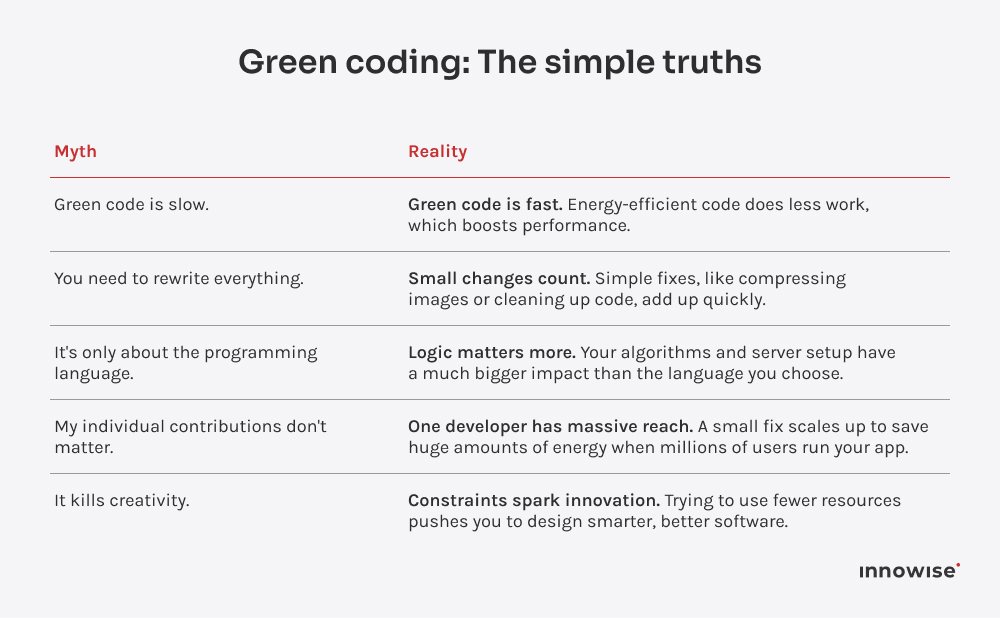

Każda konferencja technologiczna w 2026 ma co najmniej jeden panel poświęcony zrównoważonemu rozwojowi. I choć raz nie są to tylko gołosłowne deklaracje. Efektywność energetyczna zmieniła się z “fajnej rzeczy do zrobienia” w rzeczywisty KPI. Zespoły śledzą pobór mocy swoich aplikacji, optymalizują interfejsy API i projektują pod kątem mniejszego zużycia mocy obliczeniowej.

Dlaczego teraz? Dwa powody: koszty i sumienie. Rachunki za Cloud eksplodowały, a przepisy dotyczące raportowania emisji dwutlenku węgla stały się poważne. Kiedy płacisz za każdy przesłany gigabajt i każdy spalony wat, znów zaczynasz dbać o optymalizację.

Deweloperzy myślą teraz w kategoriach dżuli na funkcję. Ciężkie animacje, ciągłe odpytywanie, zbyt duże biblioteki - wszystko to nadaje się do refaktoryzacji. Frameworki takie jak Flutter 3.19 i React Native 0,76 dodano narzędzia do profilowania, które wizualizują obciążenie procesora i wpływ na baterię w czasie rzeczywistym. Zespoły back-endowe dostrajają wywołania API do przetwarzania wsadowego zamiast gadatliwych, energochłonnych pętli.

Nawet wnioskowanie AI przeszło metamorfozę pod kątem zrównoważonego rozwoju. Zamiast uruchamiać ogromne modele w chmurze, zespoły używają skwantyfikowany, destylowany, lub zoptymalizowany pod kątem krawędzi wersje. Ta sama funkcjonalność, mniejsze zużycie energii. A jeśli brzmi to mało, pamiętaj o tym: aplikacje mobilne łącznie zużywają miliardy kilowatogodzin rocznie. Wydajność na dużą skalę to wpływ na dużą skalę.

Firmy wyznaczają również wymierne cele, a nie tylko banery “dbamy o planetę”. Google Play i App Store wyróżniają teraz aplikacje o niższym zużyciu energii i efektywnym wykorzystaniu zasobów. Taka widoczność ma bezpośredni wpływ na liczbę instalacji i utrzymanie użytkowników.

Wielokrotność badania dowodzą , który konsumenci preferują marki, które działają w sposób zrównoważony, i produkty cyfrowe nie są wyjątkiem. Zielona inżynieria stała się częścią tożsamości marki.

Kiedy więc ktoś mówi “zrównoważone kodowanie”, nie chodzi o wyłączanie świateł w biurze. Chodzi o budowanie systemów, które nie marnują energii, pieniędzy ani uwagi. Wydajny kod są nowoczesny design.

Pamiętasz, kiedy platformy low-code były tylko zabawkami dla marketerów? Te czasy już minęły. W 2026, Są to poważne narzędzia zwiększające produktywność, a zespoły używają ich bez przeprosin.

Power Apps, Mendix i OutSystems zmieniają osoby niebędące programistami w produktywnych współpracowników, podczas gdy zespoły programistów podłączają te narzędzia bezpośrednio do potoków CI / CD, aby obsługiwać wewnętrzne pulpity nawigacyjne, szybkie MVP, a nawet przepływy pracy klasy produkcyjnej.

Szybkość nie oznacza już chodzenia na skróty. Oznacza skupienie inżynierów tam, gdzie mają największe znaczenie. Visual Dev obsługuje rutynowe CRUD; niestandardowy kod obsługuje skalę, bezpieczeństwo i przypadki brzegowe. Wszyscy wygrywają.

Na górze znajduje się również nowa warstwa: Niskopoziomowy kod wspomagany przez AI. Tools automatycznie uzupełniają teraz funkcje, sugerują układy interfejsu użytkownika i generują skrypty integracyjne na podstawie zwykłych monitów tekstowych. Nie zastępuje to deweloperów, ale usuwa żmudną pracę, za którą nikt nie tęskni.

Firmy, które opanowały ten hybrydowy model, szybciej dostarczają produkty, więcej eksperymentują i tracą mniej czasu na “hydraulikę”. Na rynku, na którym zwykle wygrywa ten, kto pierwszy się na nim pojawi, jest to przewaga konkurencyjna, którą warto określić ilościowo.

Low-code nie jest przyszłością. To przepływ pracy, którego już teraz potrzebujesz, aby pozostać w grze.

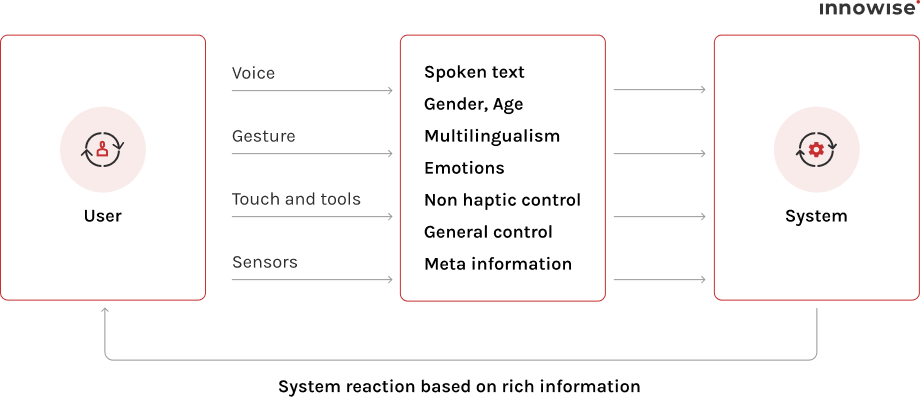

Ekrany dotykowe wciąż tu są, ale nie odgrywają już głównej roli. Głos, gesty i interakcje oparte na spojrzeniu wkraczają w centrum uwagi, po cichu zmieniając znaczenie “interfejsu użytkownika”.

W 2026, Użytkownicy oczekują, że będą rozmawiać z aplikacjami, a nie tylko je dotykać. Asystenci głosowi obsługują nawigację w aplikacji, dyktowanie wiadomości, a nawet wypełnianie formularzy bez przerywania kontekstu. Pomyśl o tym, jakby interfejs użytkownika w końcu nauczył się słuchać. Apple śledzenie wzroku w iOS 18, multimodalne interfejsy API Androida oraz Modele mowy na urządzeniu, takie jak Whisper Edge sprawiają, że jest to wystarczająco płynne do codziennego użytku.

Dla deweloperów oznacza to projektowanie pod kątem różnorodności danych wejściowych. Polecenia pochodzą z mikrofonów, kamer i czujników, a nie tylko z palców. Aplikacja fitness odczytuje gesty podczas treningu; aplikacja do dostarczania potwierdza działania szybkim “tak” wypowiedzianym na głos. Poprawia się również dostępność, ponieważ multimodalny UX naturalnie dostosowuje się do różnych umiejętności i środowisk.

Prawdziwa moc tkwi w orkiestracji. Kiedy głos, dotyk i ruch łączą się w jeden model interakcji, tarcie znika. Użytkownik może rozpocząć rezerwację za pomocą polecenia głosowego, dostosować szczegóły za pomocą gestu i potwierdzić dotknięciem. Wszystko w ramach tego samego przepływu.

Jak podaje Global Market Insights, rynek interfejsów multimodalnych rośnie w tempie ponad 16% CAGR do 2032 r., napędzany przez asystentów AI i wdrażanie obliczeń przestrzennych. Ten wzrost mówi wszystko: ludzie nie chcą już aplikacji, które czekają na dane wejściowe, chcą takich, które nadążają.

Dla zespołów produktowych wniosek jest prosty: projektuj pod kątem konwersacji, a nie tylko konsumpcji. Następna generacja mobilnego UX jest bardziej ludzka, ponieważ dźwięki człowiek.

Tworzenie aplikacji mobilnych w 2026 jest jak orkiestracja precyzji i kreatywności. Kopiloty AI przyspieszają dostarczanie, natywne systemy brzegowe obsługują obciążenia w czasie rzeczywistym, a Projektowanie zorientowane na prywatność utrzymuje zaufanie w centrum uwagi. Każdy element, od kodu po UX, współpracuje ze sobą, tworząc produkty, które są płynne i żywe.

Najlepsze zespoły tworzą z zamiarem. Zaczynają od wielu platform, automatyzują rutynowe zadania, głęboko personalizują doświadczenia i kodują z myślą o wydajności. Każda funkcja zasługuje na swoje miejsce, każde wydanie jest przemyślane.

Dla każdego, kto planuje swój kolejny cykl produktowy, rok 2026 jest rokiem, w którym należy budować z jasnością. Skoncentruj się na ekosystemach, inteligencji i długoterminowej wartości. Takie podejście sprawi, że dobre aplikacje staną się punktami odniesienia dla branży.

Wiadomość została wysłana.

Przetworzymy Twoją prośbę i skontaktujemy się z Tobą tak szybko, jak to możliwe.

Rejestrując się, wyrażasz zgodę na naszą Polityką Prywatności, w tym korzystanie z plików cookie i przekazywanie Twoich danych osobowych.