Il tuo messaggio è stato inviato.

Elaboreremo la vostra richiesta e vi ricontatteremo al più presto.

Il modulo è stato inviato con successo.

Ulteriori informazioni sono contenute nella vostra casella di posta elettronica.

Selezionare la lingua

Apache Airflowè un servizio robusto, open-source e scritto in Python utilizzato da Data Engineers per orchestrare flussi di lavoro e pipeline evidenziando le dipendenze, il codice, i registri, le attività di trigger, l'avanzamento e lo stato di successo delle pipeline per risolvere i problemi quando necessario. .

Se l'attività viene completata o fallisce, questa soluzione flessibile, scalabile e compatibile con i dati esterni è in grado di inviare avvisi e messaggi via Slack o e-mail. Apache non impone restrizioni sull'aspetto del flusso di lavoro e dispone di un'interfaccia facile da usare per monitorare e rilanciare i lavori.

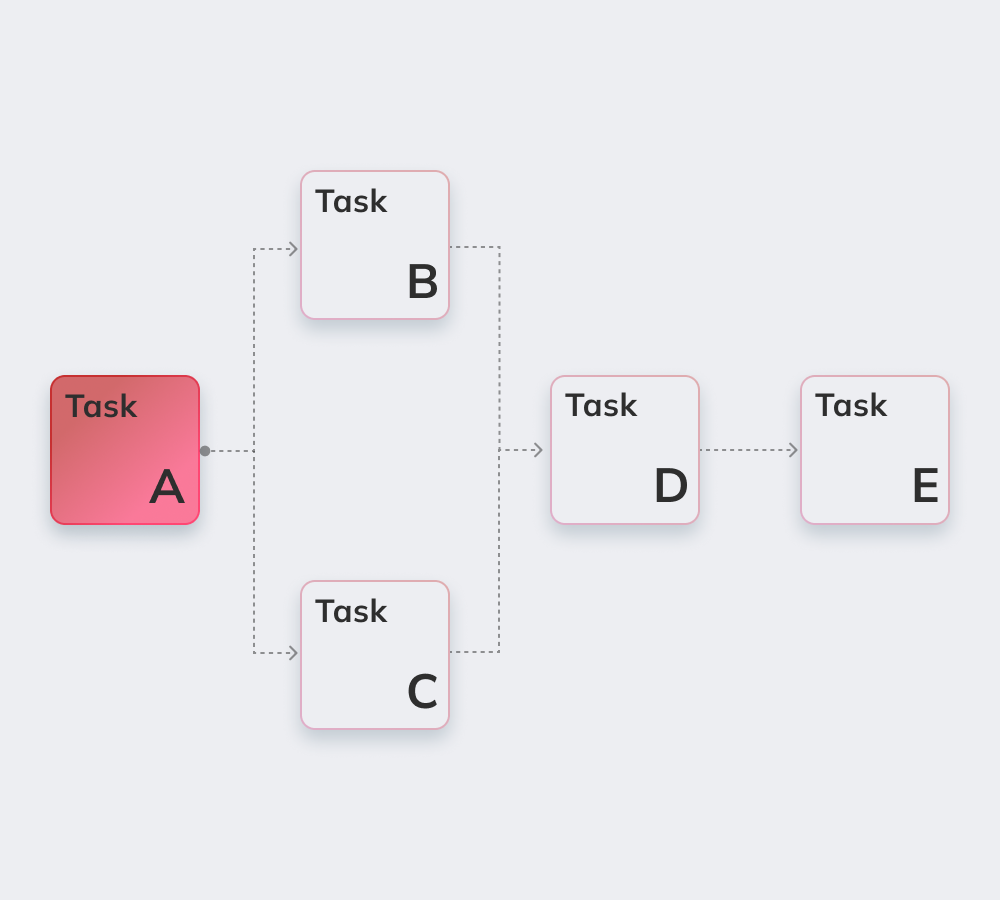

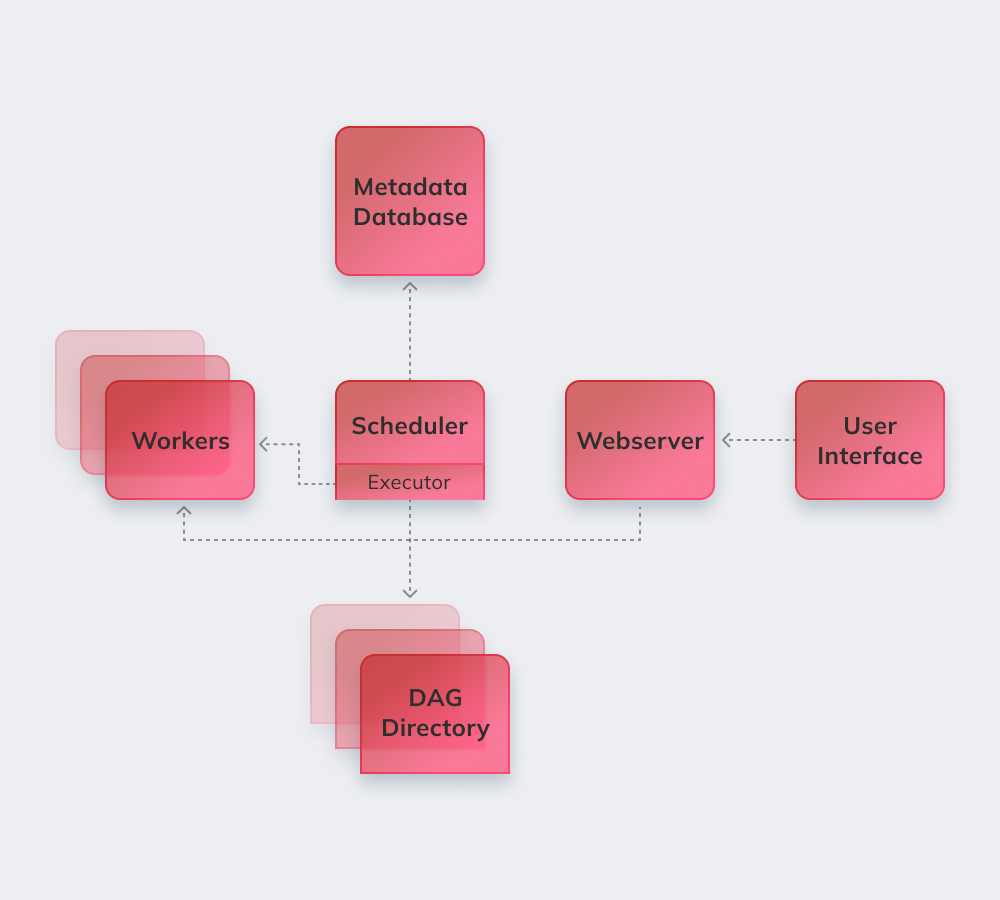

Infine, dimostriamo come funziona Apache con un semplice esempio. Innanzitutto, Apache rivede tutti i DAG in background. Le attività urgenti che devono essere completate ricevono il marchio SCHEDULED nel database. Lo Scheduler recupera i task dal database e li distribuisce agli Executor. Successivamente, i compiti ricevono lo stato QUEUED e, una volta che i lavoratori iniziano a eseguirli, viene assegnato lo stato RUNNING al lavoro. Quando l'attività è completata, il lavoratore la indica come conclusa/fallita, a seconda del successo del risultato finale, e lo Scheduler aggiorna lo stato nel database.

Di seguito elenchiamo le caratteristiche più interessanti di Apache Airflow.

La conoscenza di base di Python è l'unico requisito per costruire soluzioni sulla piattaforma.

Il servizio è gratuito, con molti utenti attivi in tutto il mondo.

Si può lavorare senza problemi con i prodotti complementari di Microsoft Azure, Google Cloud Platform, Amazon AWS, ecc.

È possibile monitorare lo stato delle attività pianificate e in corso in tempo reale.

Di seguito vengono illustrati i principi di base di Apache Airflow.

Le condutture del flusso d'aria sono configurate come Codice Python per rendere dinamica la generazione delle condotte.

Gli utenti possono creare operatori, esecutori e librerie definiti e adatti al loro specifico ambiente aziendale.

Il servizio non si blocca perché ha un'architettura modulare e può essere scalato all'infinito.

Tra questi vi sono l'automazione, la comunità, la visualizzazione dei processi aziendali, nonché il monitoraggio e il controllo adeguati. Li analizzeremo brevemente tutti.

Ci sono più di 1000 collaboratori al servizio open-source. Partecipano regolarmente al suo aggiornamento.

Apache è uno strumento perfetto per generare un "quadro generale" del proprio sistema di gestione del flusso di lavoro.

L'automazione rende più agevole il lavoro dei Data Engineer e migliora le prestazioni complessive.

Il sistema di avvisi e notifiche integrato consente di definire le responsabilità e di attuare le correzioni.

Molte piattaforme di ingegneria dei dati basate su Airflow utilizzano la logica e i vantaggi di base del servizio e aggiungono nuove funzionalità per risolvere sfide specifiche. Possono essere chiamate alternative di Apache Airflow poiché hanno funzionalità piuttosto simili:

Amazon Managed Workflows for Apache Airflow - un servizio di orchestrazione di flussi di lavoro Airflow gestito per impostare e gestire pipeline di dati su Amazon Web Services (AWS).

Apache è un potente strumento per l'ingegneria dei dati compatibile con servizi e piattaforme di terze parti. La migrazione ad Airflow avviene senza problemi, indipendentemente dalle dimensioni e dalle specifiche dell'azienda.

Innowise offre una profonda esperienza Apache di qualsiasi complessità e portata. Apache Airflow è la scelta perfetta per portare ordine se un cliente soffre di scarsa comunicazione tra i reparti e cerca maggiore trasparenza nei flussi di lavoro.

I nostri sviluppatori specializzati implementeranno un sistema modulare altamente personalizzato che migliora l'operatività con i big data e rende i processi di Airflow completamente gestiti e adattabile alle peculiarità del vostro ambiente aziendale.

Valuta questo articolo:

4.8/5 (45 recensioni)

Il tuo messaggio è stato inviato.

Elaboreremo la vostra richiesta e vi ricontatteremo al più presto.

Iscrivendosi si accetta il nostro Informativa sulla privacy, compreso l'uso dei cookie e il trasferimento dei vostri dati personali.