Ihre Nachricht wurde gesendet.

Wir werden Ihre Anfrage bearbeiten und uns so schnell wie möglich mit Ihnen in Verbindung setzen.

Das Formular wurde erfolgreich abgeschickt.

Weitere Informationen finden Sie in Ihrem Briefkasten.

Sprache auswählen

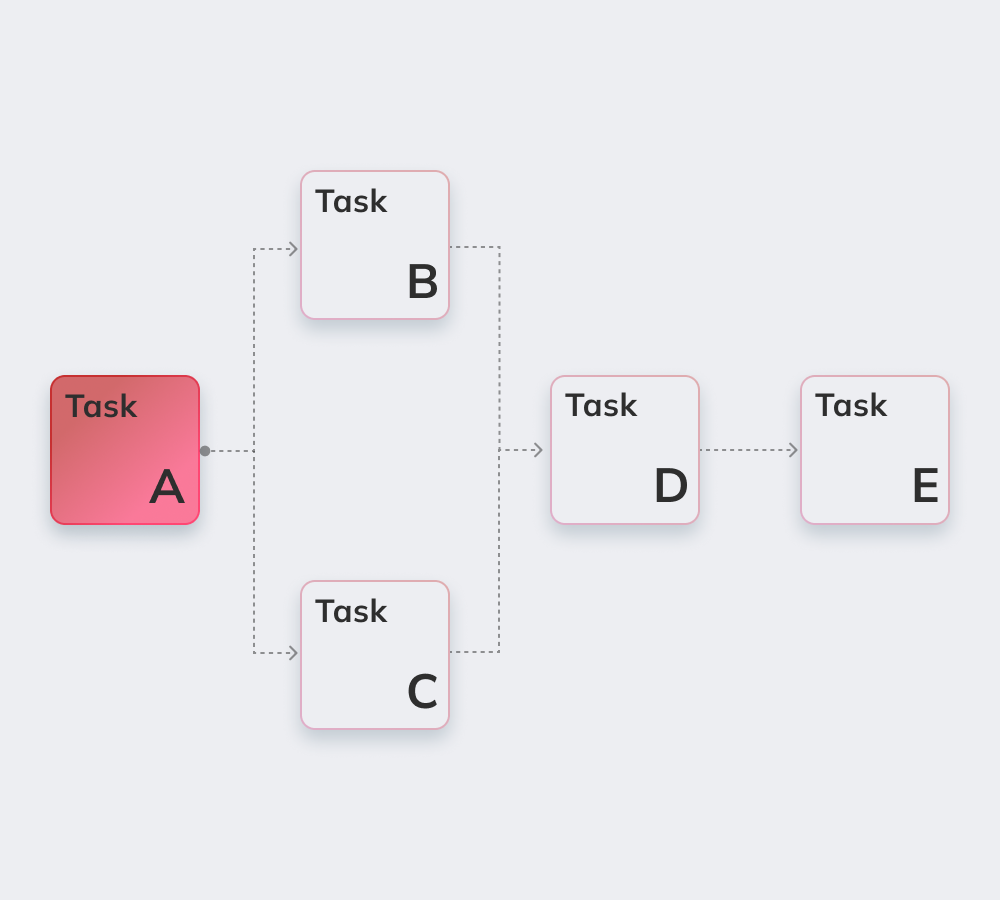

Apache Airflow ist ein robustes Open-Source-Tool in Python, mit dem Data Engineers Workflows und Pipelines steuern, Abhängigkeiten, Code, Logs, Aufgaben, Fortschritt und Status überwachen und bei Bedarf Probleme beheben.

Bei Abschluss oder Fehler sendet die flexible, skalierbare Lösung Benachrichtigungen per Slack oder E-Mail. Apache Airflow setzt keine Vorgaben für Workflows und bietet eine benutzerfreundliche Oberfläche zum Überwachen und Neustarten von Jobs.

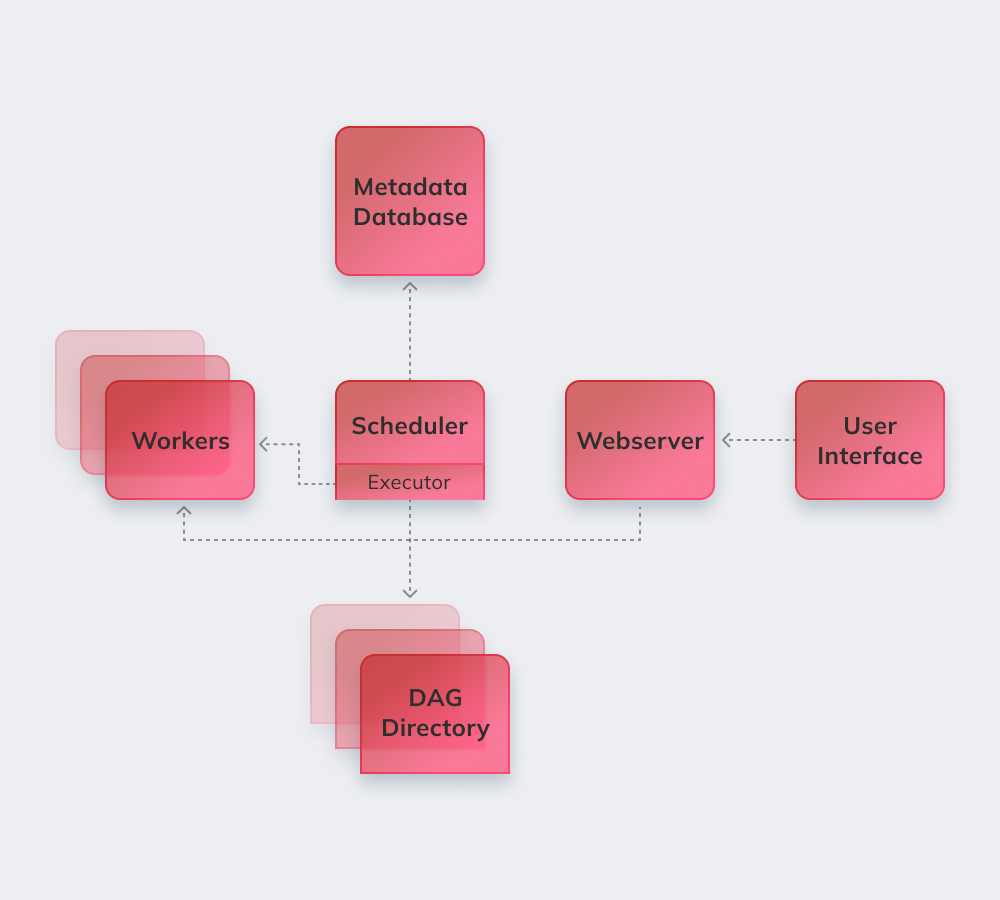

Apache prüft im Hintergrund alle DAGs. Dringende Aufgaben werden als SCHEDULED markiert, vom Scheduler an Executor verteilt, erhalten QUEUED und dann RUNNING. Nach Abschluss meldet der Worker Erfolg oder Fehler, der Scheduler aktualisiert den Status.

Nachfolgend listen wir die aufregendsten Merkmale von Apache Airflow auf.

Grundlegende Python-Kenntnisse sind die einzige Voraussetzung, um Lösungen auf der Plattform zu erstellen.

Der Dienst ist kostenlos und hat weltweit viele aktive Benutzer.

Man kann nahtlos mit ergänzenden Produkten von Microsoft Azure, Google Cloud Platform, Amazon AWS usw. arbeiten.

Sie können den Status geplanter und laufender Aufgaben in Echtzeit verfolgen.

Informieren Sie sich unten über die grundlegenden Prinzipien von Apache Airflow.

Airflow-Pipelines werden als Python-Code konfiguriert, um die Generierung von Pipelines dynamisch zu gestalten.

Benutzer können definierte Operatoren, Executoren und Bibliotheken erstellen, die für ihre spezifische Geschäftsumgebung geeignet sind.

Der Dienst stürzt nicht ab, da er eine modulare Architektur hat und unbegrenzt skaliert werden kann.

Dazu gehören Automatisierung, Community, Visualisierung von Geschäftsprozessen sowie eine angemessene Überwachung und Kontrolle. Wir werden sie alle kurz durchgehen.

Mehr als 1.000 Mitwirkende leisten ihren Beitrag zum Open-Source-Dienst und beteiligen sich regelmäßig an dessen Aktualisierung.

Apache ist ein perfektes Tool, um einen „größeren Überblick“ über das eigene Workflow-Management-System zu erhalten.

Durch die Automatisierung wird die Arbeit von Dateningenieuren reibungsloser und die Gesamtleistung verbessert.

Das integrierte Warn- und Benachrichtigungssystem ermöglicht das Festlegen von Verantwortlichkeiten und das Implementieren von Korrekturen.

Viele Airflow-basierte Plattformen erweitern die Grundfunktionen und gelten als ähnliche Alternativen:

Amazon Managed Workflows for Apache Airflow – ein verwalteter Service zur Orchestrierung von Airflow-Workflows für Datenpipelines auf AWS.

Apache ist ein leistungsstarkes Data-Engineering-Tool, kompatibel mit Drittanbietern. Die Migration zu Airflow verläuft reibungslos, unabhängig von Unternehmensgröße und Anforderungen.

Innowise bietet umfassende Apache-Expertise. Apache Airflow ist ideal, um bei schlechter Abteilungskommunikation für mehr Transparenz in Workflows zu sorgen.

Unsere Entwickler setzen mit Apache Airflow ein modulares System um, das große Datenmengen effizient verarbeitet, Workflows an Ihre Geschäftsprozesse anpasst und vollständig verwaltet.

Bewerten Sie diesen Artikel:

4.8/5 (37 bewertungen)

Ihre Nachricht wurde gesendet.

Wir werden Ihre Anfrage bearbeiten und uns so schnell wie möglich mit Ihnen in Verbindung setzen.

Mit der Anmeldung erklären Sie sich mit unseren Datenschutzrichtlinie