A sua mensagem foi enviada.

Processaremos o seu pedido e contactá-lo-emos logo que possível.

O formulário foi enviado com sucesso.

Encontrará mais informações na sua caixa de correio.

Selecionar a língua

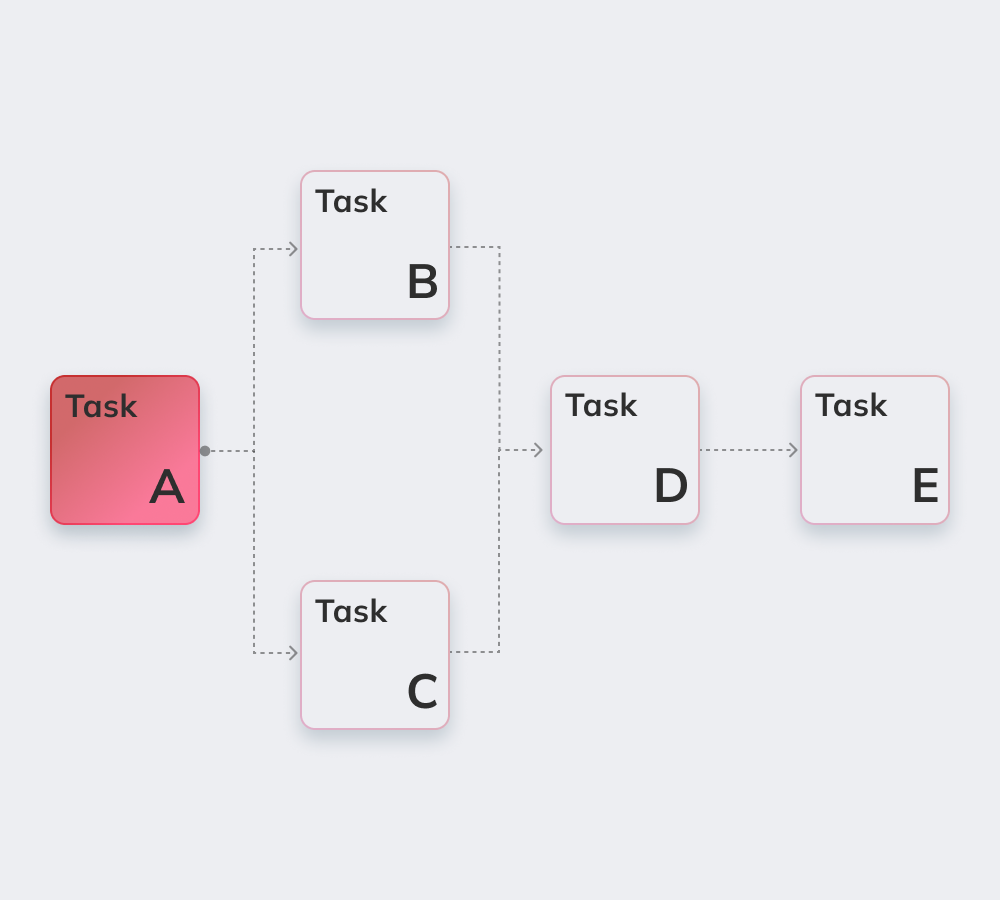

O Apache Airflow é um serviço robusto, de código aberto, escrito em Python, usado por Engenheiros de dados para orquestrar fluxos de trabalho e pipelines, destacando as dependências, o código, os logs, as tarefas de acionamento, o progresso e o status de sucesso dos pipelines para solucionar problemas quando necessário.

Se a tarefa for concluída ou falhar, esta solução flexível, escalável e compatível com dados externos é capaz de enviar alertas e mensagens através do Slack ou do correio eletrónico. O Apache não impõe restrições quanto ao aspeto do fluxo de trabalho e possui uma interface fácil de utilizar para acompanhar e executar novamente as tarefas.

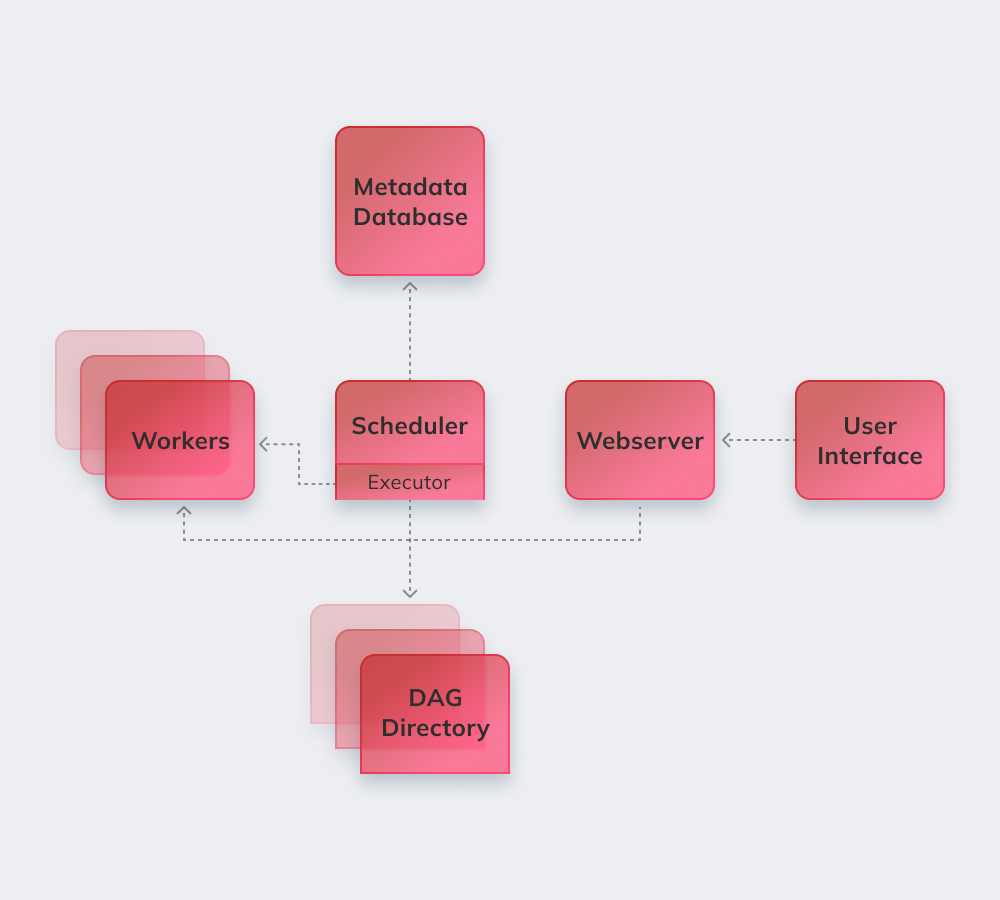

Finalmente, vamos demonstrar como o Apache funciona num exemplo simples. Em primeiro lugar, o Apache revê todos os DAGs em segundo plano. As tarefas urgentes que precisam de ser concluídas recebem a marca SCHEDULED na base de dados. O Agendador recupera as tarefas da base de dados e distribui-as pelos Executores. Depois disso, as tarefas recebem o estado QUEUED e, quando os trabalhadores começam a executá-las, é atribuído o estado RUNNING à tarefa. Quando a tarefa é concluída, o trabalhador indica-a como concluída/fracassada, dependendo do sucesso do resultado final, e o Programador de tarefas actualiza o estado na base de dados.

Abaixo, listamos as características mais interessantes do Apache Airflow.

O conhecimento básico de Python é o único requisito para construir soluções na plataforma.

O serviço é gratuito, com muitos utilizadores activos em todo o mundo.

É possível trabalhar sem problemas com produtos complementares de Microsoft Azure, Google Cloud Platform, Amazon AWS, etc.

Pode acompanhar o estado das tarefas agendadas e em curso em tempo real.

Saiba mais sobre os princípios básicos do Apache Airflow abaixo.

As condutas de fluxo de ar são configuradas como Código Python para tornar dinâmica a geração de condutas.

Os utilizadores podem criar operadores, executores e bibliotecas definidos, adequados ao seu ambiente empresarial específico.

O serviço não falha, uma vez que tem uma arquitetura modular e pode ser escalado até ao infinito.

Estas incluem a automatização, a comunidade, a visualização dos processos empresariais, bem como a monitorização e o controlo adequados. Iremos passar brevemente em revista todos eles.

O serviço de código aberto conta com mais de 1000 colaboradores. Estes participam regularmente na sua atualização.

O Apache é uma ferramenta perfeita para gerar uma "visão global" do sistema de gestão do fluxo de trabalho.

A automatização facilita o trabalho dos engenheiros de dados e melhora o desempenho global.

O sistema integrado de alertas e notificações permite definir responsabilidades e implementar correcções.

Muitas plataformas de engenharia de dados com o Airflow utilizam a lógica básica e os benefícios do serviço e adicionam novos recursos para resolver desafios específicos. Podem ser designadas por alternativas ao Airflow da Apache, uma vez que têm funcionalidades bastante semelhantes:

Amazon Managed Workflows for Apache Airflow - um serviço de orquestração de fluxo de trabalho Airflow gerido para configurar e operar pipelines de dados no Amazon Web Services (AWS).

O Apache é uma poderosa ferramenta de engenharia de dados compatível com serviços e plataformas de terceiros. A migração para o Airflow é simples e sem problemas, independentemente da dimensão e das especificações da empresa.

O Grupo Innowise oferece uma profunda experiência em Apache de qualquer complexidade e âmbito. O Apache Airflow é a escolha perfeita para trazer ordem se um cliente sofre de má comunicação entre departamentos e procura mais transparência nos fluxos de trabalho.

Os nossos programadores especializados irão implementar um sistema modular altamente personalizado que melhora a operação com grandes volumes de dados e torna os processos Airflow totalmente geridos e adaptável às particularidades do seu ambiente empresarial.

Avaliar este artigo:

4.8/5 (45 comentários)

A sua mensagem foi enviada.

Processaremos o seu pedido e contactá-lo-emos logo que possível.

Ao inscrever-se, o utilizador concorda com a nossa Política de privacidadeincluindo a utilização de cookies e a transferência das suas informações pessoais.