Ditt meddelande har skickats.

Vi behandlar din begäran och återkommer till dig så snart som möjligt.

Formuläret har skickats in framgångsrikt.

Ytterligare information finns i din brevlåda.

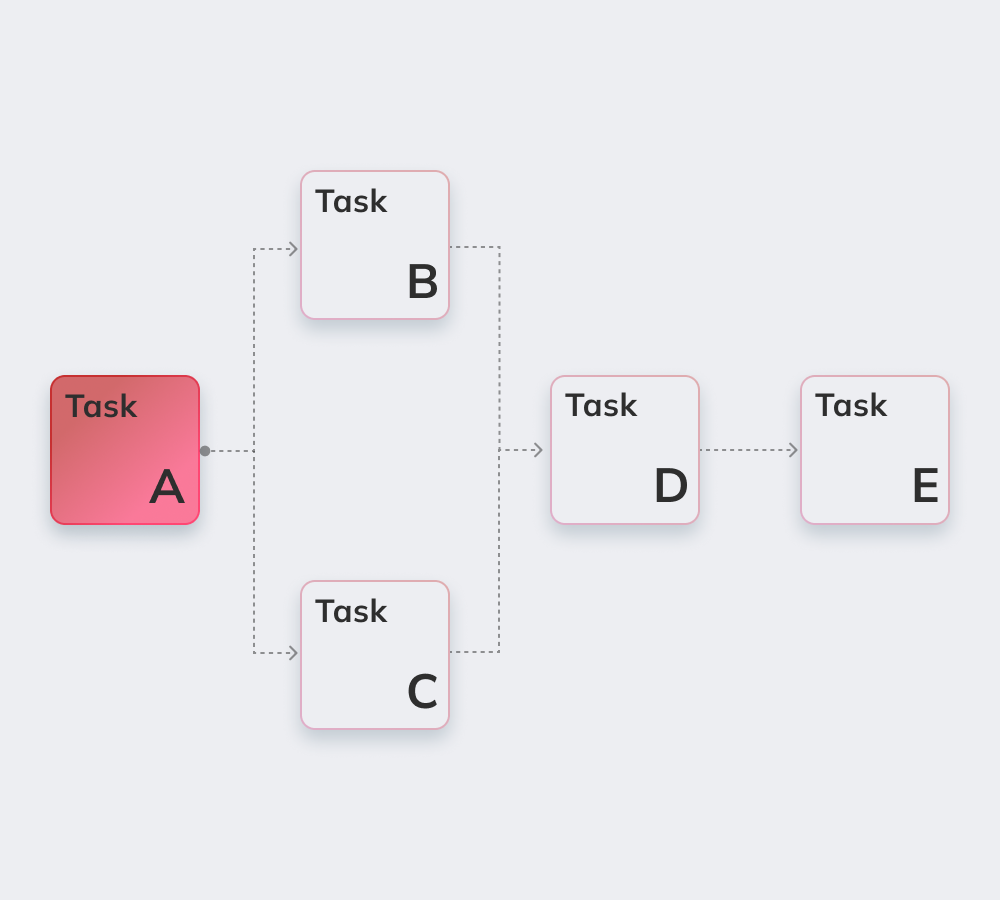

Apache Airflow är en robust, öppen källkod, Python-skriven tjänst som används av Data Engineers för att orkestrera arbetsflöden och pipelines genom att markera pipelines beroenden, kod, loggar, triggeruppgifter, framsteg och framgångsstatus för att felsöka problem vid behov.

Om uppgiften slutförs eller misslyckas kan denna flexibla, skalbara och kompatibla med extern datalösning skicka varningar och meddelanden via Slack eller e-post. Apache ställer inte in begränsningar för hur arbetsflödet ska se ut och har ett användarvänligt gränssnitt för att spåra och köra om jobb.

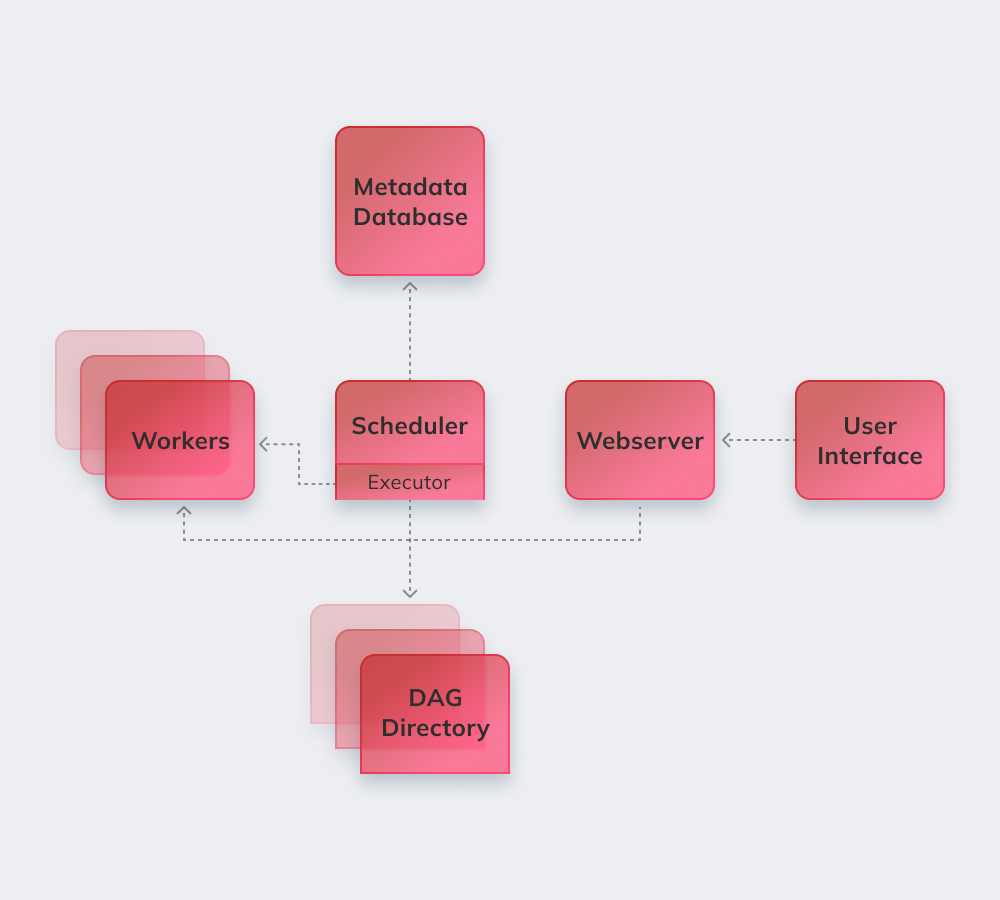

Slutligen, låt oss visa hur Apache fungerar på ett enkelt exempel. För det första reviderar Apache alla dag i bakgrunden. Brådskande uppgifter som måste slutföras får märket schemalagt i databasen. Schemaläggaren hämtar uppgifter från databasen och distribuerar dem till exekutörer. Därefter får uppgifterna status i kö, och när arbetarna börjar utföra dem tilldelas körstatus till jobbet. När uppgiften är klar anger arbetaren att den är klar/misslyckad beroende på slutresultatet, och schemaläggaren uppdaterar statusen i databasen.

Nedan listar vi de mest spännande funktionerna i Apache Airflow.

Grundläggande Python-kunskap är det enda kravet för att bygga lösningar på plattformen.

Tjänsten är gratis, med många aktiva användare över hela världen.

Man kan sömlöst arbeta med kompletterande produkter från Microsoft Azure, Google Cloud Platform, Amazon AWS, osv.

Du kan spåra status för schemalagda och pågående uppgifter i realtid.

Lär dig mer om de grundläggande Apache Airflow-principerna nedan.

Luftflödesledningar är konfigurerade som Python-kod att göra pipelines generation dynamisk.

Användare kan skapa definierade operatörer, exekutörer och bibliotek som är lämpliga för deras specifika affärsmiljö.

Tjänsten kraschar inte eftersom den har en modulär arkitektur och kan skalas till oändlighet.

De inkluderar automatisering, gemenskap, visualisering av affärsprocesser, samt korrekt övervakning och kontroll. Vi kommer kort att gå igenom dem alla.

Det finns mer än 1000 bidragsgivare till open-source-tjänsten. De deltar regelbundet i uppgraderingen.

Apache är ett perfekt verktyg för att skapa en "större bild" av sitt arbetsflödeshanteringssystem.

Automatisering gör dataingenjörernas jobb smidigare och förbättrar den totala prestandan.

Det inbyggda systemet för varningar och meddelanden gör det möjligt att ställa in ansvar och genomföra korrigeringar.

Många datatekniska plattformar som är utrustade med Airflow använder tjänstens grundläggande logik och fördelar och lägger till nya funktioner för att lösa specifika utmaningar. De kan kallas Apache Airflow-alternativ eftersom de har ganska liknande funktioner:

Amazon Managed Workflows för Apache Airflow - en hanterad airflow workflow-orkestreringstjänst för att konfigurera och driva datapipelines på Amazon Web Services (AWS).

Apache är ett kraftfullt verktyg för datateknik som är kompatibelt med tjänster och plattformar från tredje part. Migrering till luftflöde är smidig och problemfri oavsett företagets storlek och specifikationer.

Innowise levererar djup Apache expertis av komplexitet och omfattning. Apache Airflow är ett perfekt val för att få ordning om en klient lider av dålig kommunikation mellan avdelningar och söker efter mer öppenhet i arbetsflöden.

Våra skickliga utvecklare kommer att implementera ett mycket anpassat modulsystem som förbättrar driften med big data och gör Airflow processer helt hanterade och anpassningsbar till din affärsmiljös särdrag.

Betygsätt den här artikeln:

4,8/5 (45 recensioner)

Ditt meddelande har skickats.

Vi behandlar din begäran och återkommer till dig så snart som möjligt.

Genom att registrera dig godkänner du vår Integritetspolicy, inklusive användning av cookies och överföring av din personliga information.