Viestisi on lähetetty.

Käsittelemme pyyntösi ja otamme sinuun yhteyttä mahdollisimman pian.

Lomake on lähetetty onnistuneesti.

Lisätietoja on postilaatikossasi.

Apache Airflow on vankka, avoimen lähdekoodin ja Python:n kirjoittama palvelu, jota käyttää Data Engineers työnkulkujen ja putkistojen orkestrointiin korostamalla putkistojen riippuvuuksia, koodia, lokitietoja, käynnistystehtäviä, edistymistä ja onnistumistilaa, jotta ongelmatilanteita voidaan tarvittaessa korjata.

Jos tehtävä onnistuu tai epäonnistuu, tämä joustava, skaalautuva ja ulkoisten tietojen kanssa yhteensopiva ratkaisu pystyy lähettämään hälytyksiä ja viestejä Slackin tai sähköpostin kautta. Apache ei aseta rajoituksia sille, miltä työnkulun tulisi näyttää, ja siinä on käyttäjäystävällinen käyttöliittymä tehtävien seuraamiseen ja uudelleen suorittamiseen.

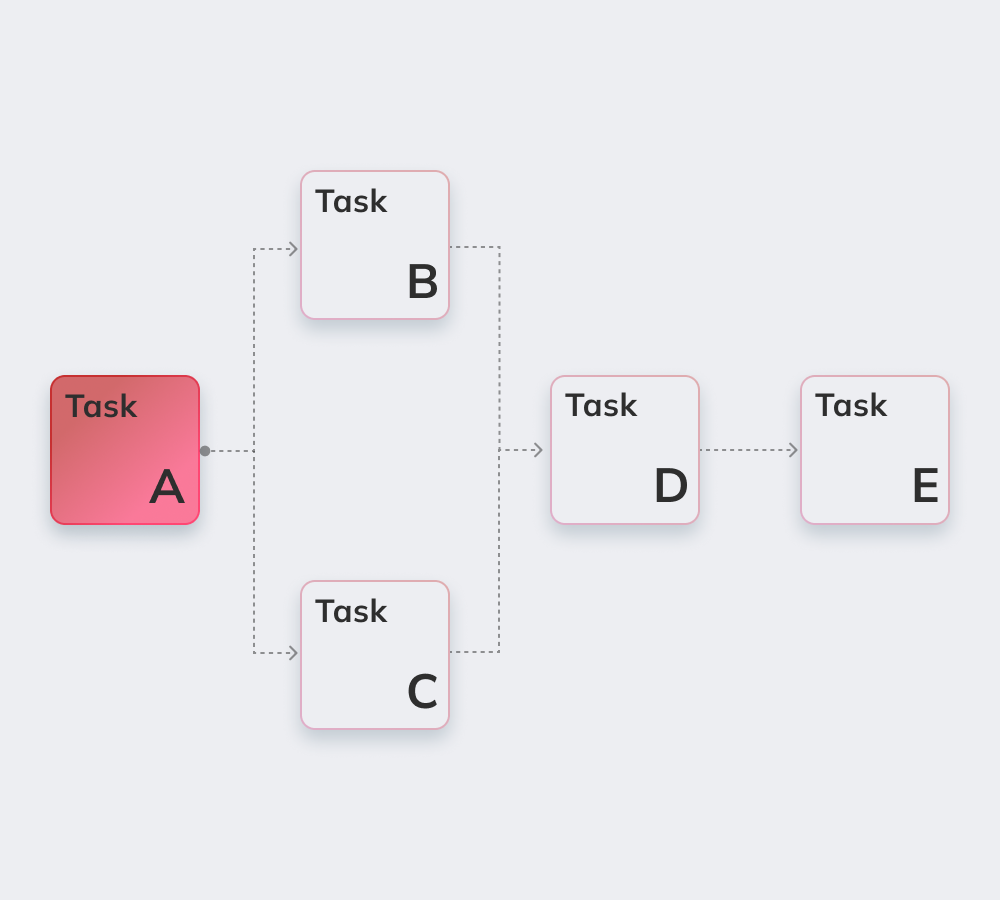

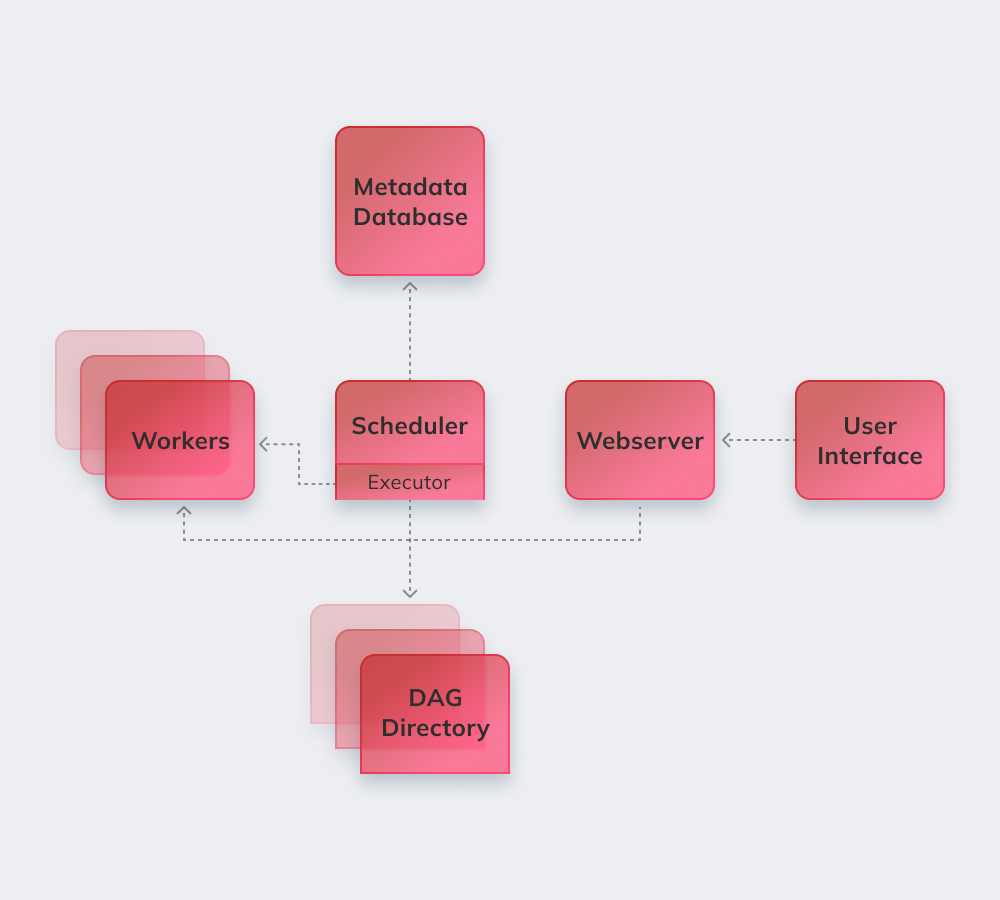

Lopuksi esitellään Apachen toimintaa yksinkertaisella esimerkillä. Ensinnäkin Apache tarkistaa kaikki DAG:t taustalla. Kiireelliset tehtävät, jotka on saatava valmiiksi, saavat merkinnän SCHEDULED tietokantaan. Scheduler hakee tehtävät tietokannasta ja jakaa ne Executoreille. Tämän jälkeen tehtävät saavat QUEUED-tilan, ja kun suorittajat alkavat suorittaa niitä, tehtävälle annetaan RUNNING-tila. Kun tehtävä on suoritettu, työntekijä ilmoittaa sen valmiiksi tai epäonnistuneeksi riippuen lopputuloksen onnistumisesta, ja Scheduler päivittää tilan tietokantaan.

Alla on lueteltu Apache Airflow'n mielenkiintoisimmat ominaisuudet.

Python:n perustiedot ovat ainoa edellytys ratkaisujen rakentamiseksi alustalle.

Palvelu on ilmainen, ja sillä on paljon aktiivisia käyttäjiä maailmanlaajuisesti.

Yksi voi saumattomasti työskennellä toisiaan täydentävien tuotteiden kanssa seuraavista yrityksistä Microsoft Azure, Google Cloud Platform, Amazon AWS jne.

Voit seurata aikataulutettujen ja käynnissä olevien tehtävien tilaa reaaliajassa.

Tutustu Apache Airflow'n perusperiaatteisiin alla.

Ilmavirtausputkistot on konfiguroitu seuraavasti Python-koodi tehdä putkistojen sukupolvesta dynaaminen.

Käyttäjät voivat luoda määriteltyjä operaattoreita, toteuttajia ja kirjastoja, jotka soveltuvat heidän omaan liiketoimintaympäristöönsä.

Palvelu ei kaadu, koska sen arkkitehtuuri on modulaarinen ja se voidaan skaalata äärettömään.

Niihin kuuluvat automaatio, yhteisöllisyys, liiketoimintaprosessien visualisointi sekä asianmukainen seuranta ja valvonta. Käymme lyhyesti läpi ne kaikki.

Avoimen lähdekoodin palvelussa on yli 1000 osallistujaa. He osallistuvat säännöllisesti sen päivittämiseen.

Apache on täydellinen työkalu työnkulunhallintajärjestelmän "kokonaiskuvan" luomiseen.

Automaatio tekee Data Engine:n työntekijöiden työstä sujuvampaa ja parantaa yleistä suorituskykyä.

Sisäänrakennettu hälytys- ja ilmoitusjärjestelmä mahdollistaa vastuiden asettamisen ja korjausten toteuttamisen.

Useat Airflow'n tukemat tietotekniikka-alustat hyödyntävät palvelun peruslogiikkaa ja etuja ja lisäävät uusia ominaisuuksia erityishaasteiden ratkaisemiseksi. Niitä voidaan kutsua Apache Airflow -vaihtoehdoiksi, koska niillä on melko samanlainen toiminnallisuus:

Amazon Managed Workflows for Apache Airflow - hallinnoitu Airflow-työnkulun orkestrointipalvelu dataputkien perustamiseen ja käyttämiseen Amazon Web Services:ssä (AWS).

Apache on tehokas työkalu tietojenkäsittelyyn, joka on yhteensopiva kolmansien osapuolten palvelujen ja alustojen kanssa. Siirtyminen Airflow'hun on sujuvaa ja ongelmatonta yrityksen koosta ja määrittelyistä riippumatta.

Innowise tarjoaa syvällistä Apache-asiantuntemusta kaikenlaisesta monimutkaisuudesta ja laajuudesta riippumatta. Apache Airflow on täydellinen valinta järjestyksen tuomiseksi, jos asiakas kärsii huonosta osastojen välisestä kommunikaatiosta ja etsii lisää avoimuutta työnkulkuihin.

Ammattitaitoiset kehittäjämme toteuttavat pitkälle räätälöidyn modulaarisen järjestelmän, joka parantaa toimintaa big datan avulla ja tekee Airflow-prosesseista täysin hallittuja ja mukautettavissa liiketoimintaympäristösi erityispiirteisiin.

Arvioi tämä artikkeli:

4.8/5 (45 arvostelua)

Viestisi on lähetetty.

Käsittelemme pyyntösi ja otamme sinuun yhteyttä mahdollisimman pian.

Rekisteröitymällä hyväksyt Tietosuojakäytäntö, mukaan lukien evästeiden käyttö ja henkilötietojesi siirto.