Din besked er blevet sendt.

Vi behandler din anmodning og kontakter dig så hurtigt som muligt.

Formularen er blevet indsendt med succes.

Du finder yderligere information i din postkasse.

Apache Airflow er en robust, open-source, Python-skrevet tjeneste, der bruges af Data Engineers til at orkestrere workflows og pipelines ved at fremhæve pipelines' afhængigheder, kode, logfiler, triggeropgaver, fremskridt og successtatus for at fejlfinde problemer, når det er nødvendigt. </span

Hvis opgaven fuldføres eller mislykkes, kan denne fleksible, skalerbare og kompatible løsning med eksterne data sende advarsler og beskeder via Slack eller e-mail. Apache lægger ikke begrænsninger på, hvordan workflowet skal se ud, og har en brugervenlig grænseflade til at spore og genoptage jobs.

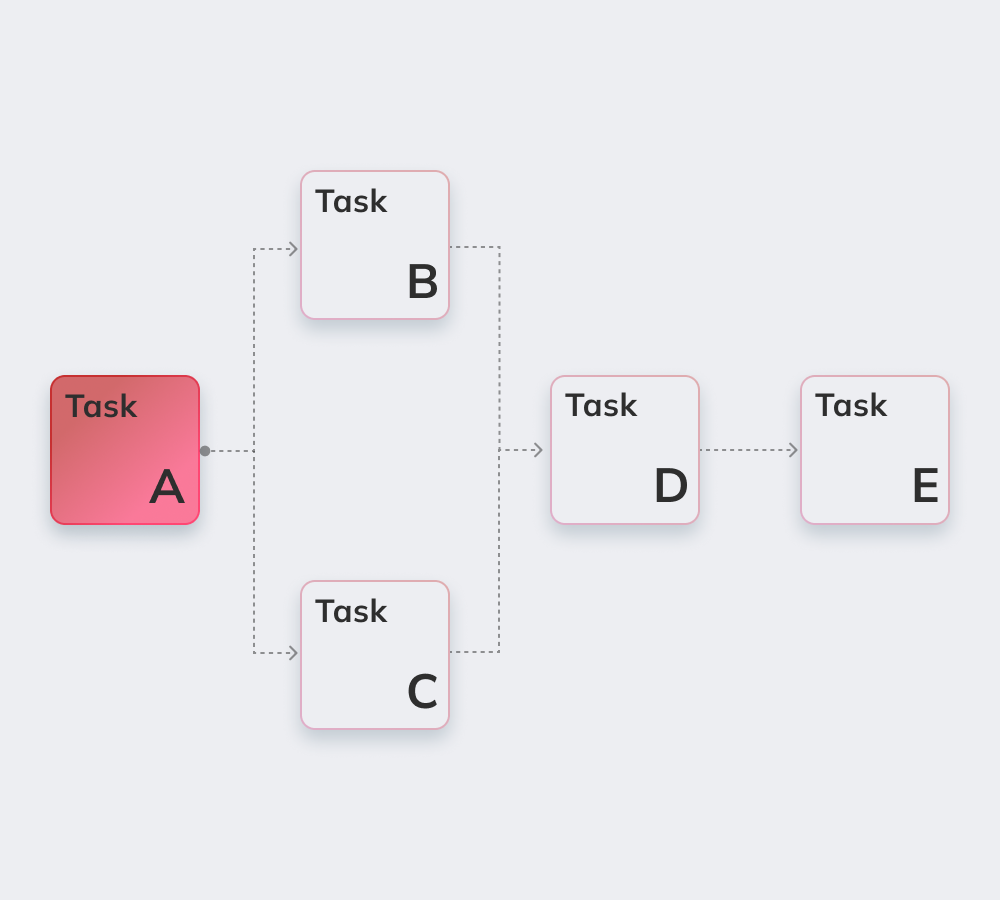

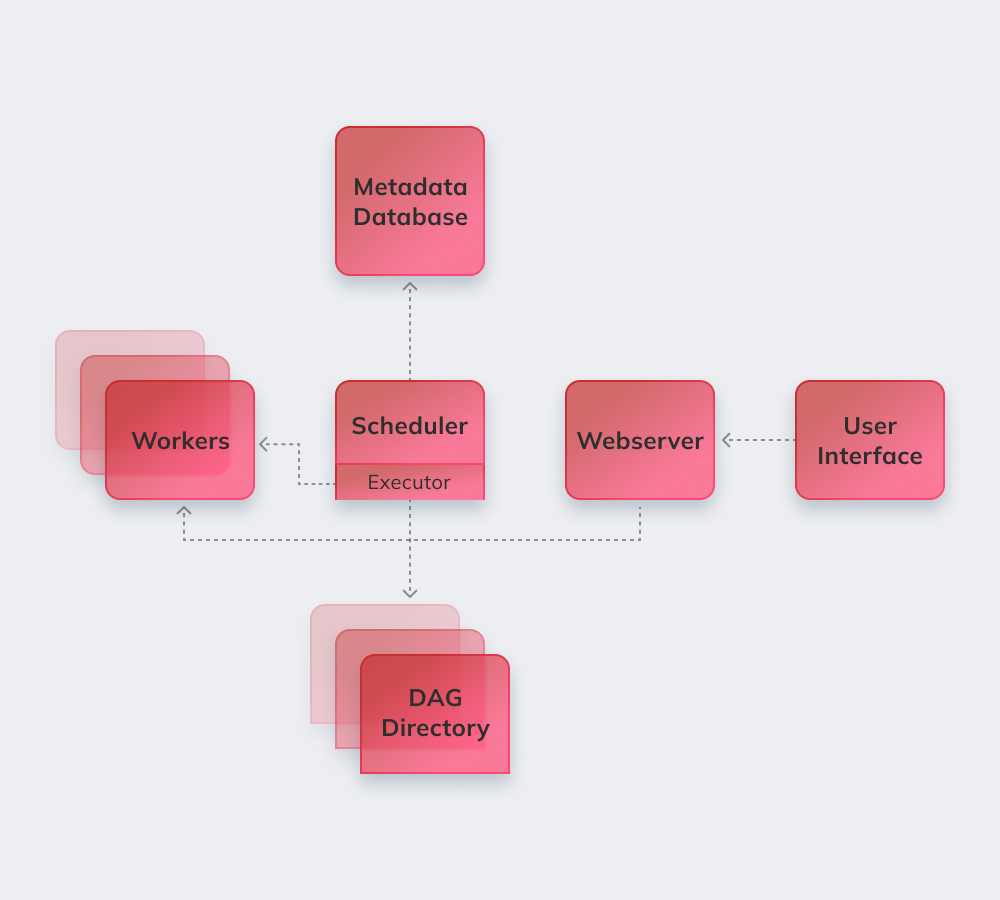

Lad os til sidst demonstrere, hvordan Apache fungerer i et simpelt eksempel. For det første reviderer Apache alle DAG'erne i baggrunden. Hastende opgaver, der skal udføres, får markeringen SCHEDULED i databasen. Scheduler henter opgaver fra databasen og distribuerer dem til Executors. Derefter får opgaverne QUEUED-status, og når medarbejderne begynder at udføre dem, tildeles jobbet RUNNING-status. Når opgaven er færdig, angiver medarbejderen den som færdig/fejlslagen afhængigt af det endelige resultat, og Scheduler opdaterer status i databasen.

Nedenfor viser vi de mest spændende funktioner i Apache Airflow.

Grundlæggende viden om Python er det eneste krav for at bygge løsninger på platformen.

Tjenesten er gratis og har mange aktive brugere over hele verden.

Man kan problemfrit arbejde med komplementære produkter fra Microsoft Azure, Google Cloud Platform, Amazon AWS osv.

Du kan følge status for planlagte og igangværende opgaver i realtid.

Lær om de grundlæggende Apache Airflow-principper nedenfor.

Luftstrømsrørledninger er konfigureret som Python-kode for at gøre genereringen af pipelines dynamisk.

Brugere kan oprette definerede operatører, eksekutorer og biblioteker, der passer til deres specifikke forretningsmiljø.

Tjenesten går ikke ned, da den har en modulær arkitektur og kan skaleres til det uendelige.

De omfatter automatisering, fællesskab, visualisering af forretningsprocesser samt korrekt overvågning og kontrol. Vi vil kort gennemgå dem alle.

Der er mere end 1000 bidragydere til open source-tjenesten. De deltager regelmæssigt i opgraderingen af den.

Apache er et perfekt værktøj til at skabe et "større billede" af ens workflow management-system.

Automatisering gør Data Engine's arbejde mere smidigt og forbedrer den samlede ydelse.

Det indbyggede advarsels- og notifikationssystem gør det muligt at fastsætte ansvarsområder og gennemføre korrektioner.

Masser af datatekniske platforme, der understøttes af Airflow, bruger den grundlæggende logik og fordelene ved tjenesten og tilføjer nye funktioner til at løse specifikke udfordringer. De kan kaldes Apache Airflow-alternativer, da de har stort set samme funktionalitet:

Amazon Managed Workflows for Apache Airflow - en administreret Airflow workflow-orkestreringstjeneste til opsætning og drift af datapipelines på Amazon Web Services (AWS).

Apache er et kraftfuldt værktøj til datateknik, der er kompatibelt med tredjepartstjenester og -platforme. Migrering til Airflow er glat og problemfri uanset virksomhedens størrelse og specifikationer.

Innowise leverer dybtgående Apache-ekspertise uanset kompleksitet og omfang. Apache Airflow er et perfekt valg til at skabe orden, hvis en kunde lider af dårlig kommunikation mellem afdelinger og søger efter mere gennemsigtighed i arbejdsgange.

Vores dygtige udviklere vil implementere et meget tilpasset modulært system, der forbedrer driften med big data og gør Airflow-processer fuldt ud styret og der kan tilpasses til dit forretningsmiljøs særlige forhold.

Bedøm denne artikel:

4.8/5 (45 anmeldelser)

Din besked er blevet sendt.

Vi behandler din anmodning og kontakter dig så hurtigt som muligt.

Ved at tilmelde dig accepterer du vores Politik for beskyttelse af personlige oplysninger, herunder brug af cookies og overførsel af dine personlige oplysninger.